Inhaltsverzeichnis

- 14.1. Die

MyISAM-Speicher-Engine - 14.2.

InnoDB-Tabellen - 14.2.1. Überblick über InnoDB-Tabellen

- 14.2.2. Kontaktinformationen

- 14.2.3. Konfiguration

- 14.2.4.

InnoDB: Startoptionen und Systemvariablen - 14.2.5. InnoDB-Tablespace erzeugen

- 14.2.6.

InnoDB-Tabellen erzeugen - 14.2.7. Hinzufügen und Entfernen von InnoDB-Daten- und -Logdateien

- 14.2.8. Sichern und Wiederherstellen einer

InnoDB-Datenbank - 14.2.9. Eine InnoDB-Datenbank auf eine andere Maschine verschieben

- 14.2.10. InnoDB-Transaktionsmodell

- 14.2.11. Tipps zur Leistungssteigerung

- 14.2.12. Implementierung der Multiversionierung

- 14.2.13. Tabellen- und Indexstrukturen

- 14.2.14. Verwaltung von Speicherplatz für Dateien und von Festplattenein- und -ausgaben

- 14.2.15.

InnoDB-Fehlerbehandlung - 14.2.16. Beschränkungen von

InnoDB-Tabellen - 14.2.17.

InnoDB-Troubleshooting

- 14.3. Die

MERGE-Speicher-Engine - 14.4. Die

MEMORY-Speicher-Engine - 14.5. Die

BDB-Speicher-Engine - 14.6. Die

EXAMPLE-Speicher-Engine - 14.7. Die

FEDERATED-Speicher-Engine - 14.8. Die

ARCHIVE-Speicher-Engine - 14.9. Die

CSV-Speicher-Engine - 14.10. Die

BLACKHOLE-Speicher-Engine

MySQL unterstützt mehrere Speicher-Engines für die Arbeit mit unterschiedlichen Tabellentypen. MySQL kennt Speicher-Engines sowohl für transaktionssichere als auch für nicht-transaktionssichere Tabellen:

Mit

MyISAMwerden nicht-transaktionssichere Tabellen verwaltet. Dieser Tabellentyp kann Daten sehr schnell speichern und abrufen und bietet Volltext-Suchfähigkeiten.MyISAMwird in allen MySQL-Konfigurationen unterstützt und ist als Standard-Tabellentyp voreingestellt, sofern Sie in MySQL keinen anderen Default konfiguriert haben.Die Speicher-Engine

MEMORYstellt Tabellen im Arbeitsspeicher zur Verfügung. Mit der Speicher-EgnineMERGElassen sich mehrere identischeMyISAM-Tabellen wie eine einzige behandeln. WieMyISAMverwalten auch die Speicher-EnginesMEMORYundMERGEnicht-transaktionssichere Tabellen. Beide sind ebenfalls standardmäßig in MySQL enthalten.Note: Die Speicher-Engine

MEMORYhieß früherHEAP.Die Speicher-Engines

InnoDBundBDBstellen transaktionssichere Tabellen zur Verfügung.BDBist in den Binärdistributionen von MySQL-Max für Betriebssysteme, die dieses unterstützen, enthalten. Außerdem istInnoDBStandardbestandteil aller MySQL 5.1-Binärdistributionen. In Quelldistributionen können Sie diese Engines aktivieren oder deaktivieren, indem Sie MySQL nach Ihren Wünschen konfigurieren.Die Speicher-Engine

EXAMPLEist ein „Sockel“-Modul, das eigentlich gar nichts tut. Sie können mit ihr zwar Tabellen anlegen, aber keine Daten speichern oder abrufen. Sie soll lediglich im MySQL-Quellcode als Beispiel zu dienen, um zu zeigen, wie man neue Speicher-Engines schreibt. Daher ist sie vor allem für Entwickler von Interesse.NDB Clusterwird von MySQL Cluster als Speicher-Engine zur Implementierung von Tabellen genutzt, die über viele Computer partitioniert sind. Sie steht in den MySQL-Max 5.1- Binärdistributionen zur Verfügung. Dieses Speicher-Engine wird zurzeit nur von Linux, Solaris und Mac OS X unterstützt. In zukünftigen MySQL-Releases soll sie auch auf anderen Plattformen, wie etwa Windows, unterstützt werden.Die Speicher-Engine

ARCHIVEdient der Speicherung großer Datenmengen ohne Indizes mit einem sehr kleinen Speicherverbrauch.Die Speicher-Engine

CSVspeichert Daten in Textdateien in Form von kommagetrennten Werten.Die Speicher-Engine

BLACKHOLEnimmt Daten entgegen, speichert sie jedoch nicht. Abfragen liefern immer eine leere Menge zurück.Die Speicher-Engine

FEDERATEDspeichert Daten in einer Remote-Datenbank. Gegenwärtig funktioniert sie nur mit MySQL unter Verwendung der MySQL-C-Client-API. In zukünftigen Releases soll sie auch mit anderen Datenquellen mit anderen Treibern oder Client-Verbindungsmethoden funktionieren.

In diesem Kapitel werden die Speicher-Engines von MySQL beschrieben.

Eine Ausnahme bildet die Engine NDB Cluster, die

in Kapitel 16, MySQL Cluster behandelt wird.

Wenn Sie eine neue Tabelle anlegen, können Sie die zu verwendende

Speicher-Engine angeben, indem Sie der CREATE

TABLE-Anweisung die Tabellenoption

ENGINE oder TYPE hinzufügen:

CREATE TABLE t (i INT) ENGINE = INNODB; CREATE TABLE t (i INT) TYPE = MEMORY;

Der ältere Begriff TYPE wird aus Gründen der

Abwärtskompatibilität noch als Synonym für

ENGINE akzeptiert, doch ENGINE

ist der aktuelle Begriff, während TYPE

mittlerweile veraltet ist.

Wenn Sie die Option ENGINE oder

TYPE weglassen, wird die Standard-Speicher-Engine

verwendet. Normalerweise ist dies MyISAM, doch

mit der Server-Startoption --default-storage-engine

oder --default-table-type oder der Systemvariablen

storage_engine oder table_type

können Sie auch etwas anderes einstellen.

Wird MySQL unter Windows mit dem MySQL Configuration Wizard

installiert, kann die Speicher-Engine InnoDB

anstelle der standardmäßigen MyISAM-Engine

gewählt werden. Siehe

Abschnitt 2.3.5.6, „Der Dialog zur Datenbankverwendung“.

Um eine Typkonvertierung von Tabellen vorzunehmen, geben Sie in

einer ALTER TABLE-Anweisung den neuen Typ an:

ALTER TABLE t ENGINE = MYISAM; ALTER TABLE t TYPE = BDB;

Siehe Abschnitt 13.1.5, „CREATE TABLE“ und

Abschnitt 13.1.2, „ALTER TABLE“.

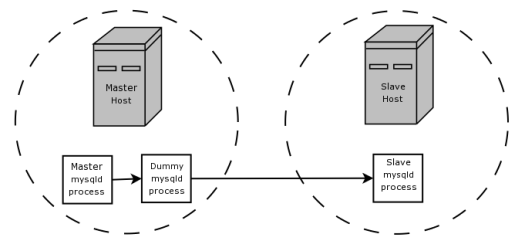

Wenn Sie eine Speicher-Engine zu verwenden versuchen, die entweder

gar nicht kompiliert oder zwar kompiliert, aber deaktiviert ist,

legt MySQL stattdessen mit der Standard-Speicher-Engine eine Tabelle

an, also normalerweise mit MyISAM. Dieses

Verhalten ist praktisch, wenn Tabellen zwischen MySQL-Servern hin-

und herkopiert werden, die verschiedene Speicher-Engines

unterstützen. (So könnte beispielsweise in einer Replikation Ihr

Masterserver aus Sicherheitsgründen transaktionssichere

Speicher-Engines verwenden, während die Slaveserver aus Gründen

der Schnelligkeit nur nicht-transaktionssichere einsetzen.)

Dass MySQL für Speicher-Engines, die nicht zur Verfügung stehen, automatisch die Standard-Speicher-Engine einsetzt, kann für Neulinge verwirrend sein. Es wird jedoch in einem solchen Fall immer eine Warnung ausgegeben.

Für neue Tabellen legt MySQL immer eine

.frm-Datei zur Speicherung der Tabellen- und

Spaltendefinitionen an. Der Index und die Daten der Tabelle können

je nach Speicher-Engine in einer oder mehreren Dateien gespeichert

sein. Der Server erstellt die .frm-Datei über

der Ebene der Speicher-Engine. Einzelne Speicher-Engines legen

zusätzliche Dateien an, die für die von ihnen verwalteten Tabellen

erforderlich sind.

Eine Datenbank kann unterschiedliche Tabellentypen enthalten; die Tabellen müssen also nicht alle mit derselben Speicher-Engine angelegt werden.

Transaktionssichere Tabellen (TSTs) haben gegenüber den nicht-transaktionssicheren (NTSTs) mehrere Vorteile:

Sie sind sicherer. Selbst wenn MySQL abstürzt oder Hardware-Probleme auftreten, bekommen Sie Ihre Daten auf jeden Fall zurück, sei es durch die automatische Wiederherstellung, sei es aus einer Sicherungskopie plus dem Transaktionslog.

Sie können viele Anweisungen miteinander kombinieren und mit der

COMMIT-Anweisung später alle gleichzeitig festschreiben (wenn Autocommit deaktiviert wurde).Sie können Ihre Änderungen mit einem

ROLLBACKverwerfen (wenn Autocommit deaktiviert wurde).Schlägt ein Update fehl, werden alle Ihre Änderungen rückgängig gemacht. (Bei nicht-transaktionssicheren Tabellen sind alle einmal stattgefundenen Änderungen von Dauer.)

Transaktionssichere Speicher-Engines bieten bessere Nebenläufigkeit für Tabellen, in denen gleichzeitig mit Lese-Operationen viele Änderungen stattfinden.

Sie können transaktionssichere und nicht-transaktionssichere

Tabellen in derselben Anweisung verwenden, um aus beiden das Beste

herauszuholen. Allerdings sollten Sie nicht bei ausgeschaltetem

Autocommit verschiedene Speicher-Engines durcheinanderwürfeln, auch

wenn MySQL mehrere transaktionssichere Engines unterstützt, um die

bestmöglichen Ergebnisse zu erzielen. Denn wenn Sie die Engines

vermischen, werden Änderungen an nicht-transaktionssicheren

Tabellen weiterhin festgeschrieben und können nicht mehr

zurückgerollt werden. Informationen zu diesem und anderen

Problemen, die in Transaktionen mit einem Mix von Speicher-Engines

auftreten können, finden Sie unter Abschnitt 13.4.1, „BEGIN/COMMIT/ROLLBACK“.

Nicht-transaktionssichere Tabellen haben mehrere Vorteile, die alle damit zusammenhängen, dass der Aufwand von Transaktionen entfällt:

Viel schneller

Weniger Speicherbedarf auf der Festplatte

Weniger Arbeitsspeicherbedarf für Updates

MyISAM ist die Standard-Speicher-Engine. Sie

baut auf dem älteren ISAM-Code auf, hat aber

viele praktische Erweiterungen. (Beachten Sie, dass MySQL

5.1 ISAMnicht

mehr unterstützt.)

Jede MyISAM-Tabelle wird in drei Dateien auf

der Festplatte gespeichert. Die Namen der Dateien beginnen mit dem

Tabellennamen und haben eine Erweiterung, die den Dateityp angibt.

Eine .frm-Datei speichert das Tabellenformat.

Die Datendatei besitzt die Erweiterung .MYD

(MYData). Die Indexdatei hat die Erweiterung

.MYI (MYIndex).

Um ausdrücklich zu sagen, dass Sie eine

MyISAM-Tabelle möchten, verwenden Sie die

Tabellenoption ENGINE:

CREATE TABLE t (i INT) ENGINE = MYISAM;

Der ältere Begriff TYPE wird aus Gründen der

Abwärtskompatibilität noch als Synonym für

ENGINE akzeptiert, doch

ENGINE ist der aktuelle Begriff, während

TYPE mittlerweile veraltet ist.

Normalerweise ist eine ENGINE-Angabe für die

MyISAM-Speicher-Engine unnötig.

MyISAM ist ohnehin die Standard-Engine, es sei

denn, die Standardeinstellung wurden geändert. Um in solchen

Situationen ganz sicherzugehen, dass MyISAM

verwendet wird, sollten Sie explizit die Option

ENGINE verwenden.

Zur Prüfung oder Reparatur von MyISAM-Tabellen

setzen Sie den mysqlcheck-Client oder das

Hilfsprogramm myisamchk ein. Überdies können

Sie MyISAM-Tabellen mit

myisampack komprimieren, dann belegen sie viel

weniger Speicherplatz. Siehe auch Abschnitt 8.9, „mysqlcheck — Hilfsprogramm für die Wartung und Reparatur von Tabellen“,

Abschnitt 5.10.4.1, „Benutzung von myisamchk für die Fehlerbeseitigung nach Abstürzen“, und

Abschnitt 8.4, „myisampack — Erzeugung komprimierter, schreibgeschützter MyISAM Tabellen“.

Kennzeichen von MyISAM-Tabellen:

Alle Daten werden mit dem niederwertigen Byte zuerst gespeichert. Dadurch werden die Daten maschinen- und betriebssystemunabhängig. Die einzigen Voraussetzungen für die binäre Portierbarkeit der Daten sind, dass der Computer vorzeichenbehaftete Integers (Zweierkomplement) und das IEEE-Fließkommaformat verwendet. Diese Voraussetzungen werden von den üblichen Computern meist erfüllt. Nur bei Embedded-Systemen mit ihren manchmal seltsamen Prozessoren ist die Binärkompatibilität nicht immer gegeben.

Die Verarbeitungsgeschwindigkeit leidet nicht sonderlich, wenn das niederwertige Byte zuerst gespeichert wird. Die Bytes in einer Tabellenzeile werden normalerweise nicht ausgerichtet und es macht zeitmäßig kaum einen Unterschied, ob ein unausgerichtetes Byte in der Reihenfolge oder gegen die Reihenfolge gelesen wird. Darüber hinaus ist der Server-Code, der die Spaltenwerte abruft, im Vergleich zu anderem Code nicht zeitkritisch.

Alle numerischen Schlüsselwerte werden mit dem höchstwertigen Byte zuerst gespeichert, um eine bessere Indexkompression zu ermöglichen.

Große Dateien (bis zu 63 Bit Dateilänge) werden für Datei- und Betriebssysteme, auf denen große Dateien möglich sind, unterstützt.

Eine

MyISAM-Tabelle kann maximal 64 Indizes haben. Dies lässt sich jedoch durch Rekompilieren ändern: Ab der Version MySQL 5.1.4 können Sie den Build konfigurieren, indem Sie configure mit der Option--with-max-indexes=aufrufen, wobeiNNdie Höchstzahl der proMyISAM-Tabelle zulässigen Indizes ist.Nmuss kleiner oder gleich 128 sein. In älteren Versionen als MySQL 5.1.4 müssen Sie die Quelle wechseln.Ein Index darf maximal 16 Spalten haben.

Die Höchstlänge für Schlüssel beträgt 1000 Bytes. Auch dies lässt sich durch Wechseln der Quelle und Rekompilieren ändern. Ist ein Schlüssel länger als 250 Bytes wird ein größerer als der standardmäßig 1024 Bytes große Schlüsselblock verwendet.

Werden Zeilen sortiert eingefügt (wie zum Beispiel mit einer

AUTO_INCREMENT-Spalte), wird der Indexbaum aufgespalten, so dass der höchste Knoten nur einen Schlüssel enthält. So wird der Platz im Indexbaum besser ausgenutzt.Intern wird eine

AUTO_INCREMENT-Spalte pro Tabelle unterstützt.MyISAMaktualisiert diese Spalte beiINSERT- undUPDATE-Operationen automatisch. Das machtAUTO_INCREMENT-Spalten schneller (um mindestens 10%). Werte am Anfang der Folge werden nach ihrer Löschung nicht wiederverwendet. (Wenn eineAUTO_INCREMENT-Spalte als die letzte Spalte eines Mehrspalten-Indizes definiert ist, werden gelöschte Werte vom Anfang einer Folge doch wiederverwendet.) DerAUTO_INCREMENT-Wert kann mitALTER TABLEoder myisamchk zurückgesetzt werden.Zeilen mit dynamischer Größenanpassung werden bei einer Mischung von Lösch-, Änderungs- und Einfügeoperationen viel weniger stark fragmentiert, da aneinander grenzende gelöschte Blöcke automatisch zusammengefasst und Blöcke, deren Nachbarblock gelöscht werden, automatisch erweitert werden.

Hat eine Tabelle in der Mitte der Datendatei keine freien Blöcke, können Sie neue Zeilen mit

INSERTeinfügen, während gleichzeitig andere Threads die Tabelle lesen. (Man nennt dies "nebenläufige Einfügeoperationen".) Wird eine Zeile gelöscht oder werden in eine Zeile dynamischer Länge mehr Daten geschrieben, als sie zuvor enthalten hatte, kann ein freier Block entstehen. Wenn alle freien Blöcke aufgebraucht (ausgefüllt) wurden, werden zukünftige Einfügeoperationen wieder nebenläufig. Siehe Abschnitt 7.3.3, „Gleichzeitige Einfügevorgänge“.Mit den Tabellenoptionen

DATA DIRECTORYundINDEX DIRECTORYvonCREATE TABLEkönnen Sie die Daten- und die Indexdatei in unterschiedliche Verzeichnisse legen, um mehr Geschwindigkeit zu erzielen. Siehe Abschnitt 13.1.5, „CREATE TABLE“.BLOB- undTEXT-Spalten können indiziert werden.NULL-Werte sind in indizierten Spalten zulässig. Hierfür werden 0 bis 1 Byte pro Schlüssel gebraucht.Jede Zeichenspalte kann einen anderen Zeichensatz haben. Siehe Kapitel 10, Zeichensatz-Unterstützung.

In der

MyISAM-Indexdatei gibt es ein Flag, das anzeigt, ob die Tabelle ordentlich geschlossen wurde. Wenn mysqld mit der Option--myisam-recovergestartet wird, werdenMyISAM-Tabellen beim Öffnen automatisch überprüft und repariert, wenn sie nicht richtig geschlossen wurden.myisamchk markiert Tabellen als geprüft, wenn Sie es mit der Option

--update-stateausführen. myisamchk --fast prüft nur diejenigen Tabellen, die diese Markierung nicht tragen.myisamchk --analyze speichert Statistikdaten sowohl für Teilschlüssel als auch für vollständige Schlüssel.

myisampack kann

BLOB- undVARCHAR-Spalten packen.

MyISAM unterstützt auch folgende Funktionen:

Unterstützung für einen echten

VARCHAR-Typ; eineVARCHAR-Spalte beginnt mit einer Längenangabe, die in einem oder zwei Byte(s) gespeichert ist.Tabellen mit

VARCHAR-Spalten können Zeilen mit fester oder dynamischer Länge haben.Die Summe der Längen der

VARCHAR-undCHAR-Spalten in einer Tabelle kann bis zu 64KB betragen.Für

UNIQUEkann ein berechneter Hash-Index verwendet werden. So istUNIQUEfür jede beliebige Spaltenkombination in einer Tabelle zulässig. (Allerdings können auf einem berechnetenUNIQUE-Index keine Suchoperationen durchgeführt werden.)

Ein spezielles Forum für die Speicher-Engine

MyISAMfinden Sie unter http://forums.mysql.com/list.php?21.

Die folgenden Optionen von mysqld können

verwendet werden, um das Verhalten von

MyISAM-Tabellen zu ändern. Weitere

Informationen finden Sie unter Abschnitt 5.2.1, „Befehlsoptionen für mysqld“.

--myisam-recover=modeStellt den Modus für die automatische Wiederherstellung von abgestürzten

MyISAM-Tabellen ein.--delay-key-write=ALLZwischen den Schreibvorgängen werden die Schlüsselpuffer (Key-Buffer) für

MyISAM-Tabellen nicht auf die Festplatte zurückgeschrieben.Note: Wenn Sie dies tun, sollten Sie auf

MyISAM-Tabellen nicht von einem anderen Programm aus zugreifen (zum Beispiel von einem anderen MySQL-Server oder mit myisamchk), so lange die Tabellen in Gebrauch sind. Sonst riskieren Sie, dass der Index beschädigt wird. Diese Gefahr wird durch--external-lockingnicht gebannt.

Die folgenden Systemvariablen beeinflussen das Verhalten von

MyISAM-Tabellen. Weitere Informationen finden

Sie unter Abschnitt 5.2.2, „Server-Systemvariablen“.

bulk_insert_buffer_sizeDie Größe des bei der Optimierung von Massen-Einfügeoperationen verwendeten Tree-Caches. Hinweis: Dieser Wert gilt pro Thread!

myisam_max_sort_file_sizeZur Indexerstellung nicht die schnelle Index-Sortiermethode verwenden, wenn die temporäre Datei dadurch größer als dieser Wert würde. Hinweis: Dieser Parameter wird in Bytes angegeben.

myisam_sort_buffer_sizeStellt die Puffergröße für die Wiederherstellung von Tabellen ein.

Wenn Sie mysqld mit der Option

--myisam-recover starten, wird die automatische

Wiederherstellung aktiviert. Wenn der Server eine

MyISAM-Tabelle öffnet, prüft er, ob sie als

abgestürzt gekennzeichnet ist oder die Zählervariable für

Öffnungen von 0 verschieden ist und Sie den Server ohne externe

Sperren betreiben. Trifft eine dieser Bedingungen zu, so

geschieht folgendes:

Der Server überprüft die Tabelle auf Fehler.

Wenn der Server einen Fehler findet, versucht er eine schnelle Tabellenreparatur (mit Sortierung, aber ohne Neuerzeugung der Datendatei).

Scheitert die Reparatur wegen eines Fehlers in der Datendatei (zum Beispiel eines doppelten Schlüssels), versucht der Server erneut eine Reparatur, aber dieses Mal mit Neuerzeugung der Datendatei.

Scheitert auch diese Reparatur, versucht es der Server noch einmal mit der alten Reparaturmethode (zeilenweises Schreiben der Daten ohne Sortierung). Dieses Verfahren müsste in der Lage sein, jeden Fehler zu beheben und braucht nur wenig Festplattenspeicher.

Wenn die Wiederherstellung nicht alle Zeilen aus den zuvor

abgeschlossenen Anweisungen wiederherstellen kann und Sie im

Wert der Option --myisam-recover nicht

FORCE angegeben haben, bricht die

automatische Reparatur ab und schreibt folgende Fehlermeldung in

das Fehler-Log:

Error: Couldn't repair table: test.g00pages

Wenn Sie FORCE angeben, wird stattdessen

folgende Warnung in das Log geschrieben:

Warning: Found 344 of 354 rows when repairing ./test/g00pages

Beachten Sie: Wenn die automatische Wiederherstellung den Wert

BACKUP enthält, legt der

Wiederherstellungsprozess Dateien an, deren Namen die Form

tbl_name-datetime.BAK

MyISAM-Tabellen verwenden B-Baum-Indizes. Die

Größe der Indexdatei, summiert über alle Schlüssel, lässt

sich mit der Formel (key_length+4)/0.67

ungefähr berechnen. Das gilt für den ungünstigsten Fall, dass

alle Schlüssel in sortierter Reihenfolge eingefügt wurden und

die Tabelle keine komprimierten Schlüssel besitzt.

String-Indizes werden Leerzeichen-komprimiert. Ist der erste

Teil des Index ein String, so wird dieser zusätzlich

präfixkomprimiert. Durch Leerzeichen-Kompression wird die

Indexdatei kleiner als in den obigen Zahlen für den

ungünstigsten Fall dargestellt, wenn eine Stringspalte viele

Leerzeichen am Ende hat oder eine

VARCHAR-Spalte ist, die nicht immer in voller

Länge ausgenutzt wird. Eine Präfix-Kompression wird für

Schlüssel eingesetzt, die mit einem String anfangen. Die

Präfix-Kompression ist hilfreich, wenn mehrere Strings mit

identischem Präfix vorhanden sind.

In MyISAM-Tabellen können Sie auch Zahlen

präfixkomprimieren. Hierzu geben Sie beim Anlegen der Tabelle

die Tabellenoption PACK_KEYS=1 an. Das hilft,

wenn Sie viele Integer-Schlüssel mit identischem Präfix haben,

wenn die Zahlen mit dem höchstwertigen Byte zuerst gespeichert

werden.

MyISAM unterstützt drei verschiedene

Speicherformate. Zwei davon, das feste und das dynamische

Format, werden automatisch anhand des verwendeten Spaltentyps

gewählt. Das dritte, komprimierte Format kann nur mit der

Utility myisampack angelegt werden.

Wenn Sie CREATE TABLE oder ALTER

TABLE für eine Tabelle verwenden, die keine

BLOB- oder TEXT-Spalten

besitzt, können Sie mit der Tabellenoption

ROW_FORMAT ein FIXED- oder

DYNAMIC-Format erzwingen.

Um Tabellen zu dekomprimieren, geben Sie

ROW_FORMAT=DEFAULT mit ALTER

TABLE zusammen an.

Unter Abschnitt 13.1.5, „CREATE TABLE“ finden Sie Informationen

über ROW_FORMAT.

Das statische (Festlängen-) Format ist für

MyISAM-Tabellen voreingestellt. Es wird

verwendet, wenn die Tabelle keine Spalten mit variabler Länge

(VARCHAR-, VARBINARY-,

BLOB- oder TEXT-Spalten)

enthält. Jede Zeile wird dann mit einer festgelegten Anzahl

von Bytes gespeichert.

Von den drei Speicherformaten, die MyISAM

unterstützt, ist das statische Format das einfachste und

sicherste (für Schäden am wenigsten anfällige). Außerdem

bietet es wegen der Leichtigkeit, mit der die Zeilen der

Datendatei auf der Festplatte gefunden werden, auch den

schnellsten Festplattenzugriff. Um eine Zeile nach der

Index-Zeilennummer nachzuschlagen, multiplizieren Sie die

Nummer der Zeile mit ihrer Länge, um ihre Position zu

ermitteln. Darüber hinaus ist es beim Durchsuchen einer

Tabelle sehr einfach, mit jedem Festplattenzugriff eine

konstante Anzahl Zeilen zu lesen.

Die Sicherheit erweist sich, wenn Ihr Computer abstürzt,

während der MySQL-Server eine MyISAM-Datei

mit festgelegtem Format schreibt. In einem solchen Fall kann

myisamchk ganz leicht feststellen, wo die

Zeilen beginnen und enden. Normalerweise ist es dadurch in der

Lage, alle Zeilen außer der einen, die nur teilweise

geschrieben wurde, zurückzugewinnen. Beachten Sie, dass

MyISAM-Tabellenindizes immer anhand der

Datenzeilen rekonstruiert werden können.

Kennzeichen von statischen Tabellen:

CHAR-Spalten werden mit Leerzeichen bis zur Spaltenbreite aufgefüllt.BINARY-Spalten werden mit0x00-Bytes bis zur Spaltenbreite aufgefüllt.Sie sind sehr schnell.

Sie lassen sich leicht zwischenspeichern.

Sie sind nach einem Absturz einfach zu rekonstruieren, da sich die Datensätze an festen Positionen befinden.

Eine Reorganisation der Tabellen ist nicht erforderlich, es sei denn, Sie löschen sehr viele Zeilen und möchten dem Betriebssystem den frei gewordenen Speicherplatz zurückgeben. Hierzu verwenden Sie

OPTIMIZE TABLEoder myisamchk -r.Sie belegen normalerweise mehr Speicher als dynamische Tabellen.

Ein dynamisches Speicherformat wird verwendet, wenn eine

MyISAM-Tabelle Spalten variabler Länge

enthält (VARCHAR-,

VARBINARY-, BLOB- oder

TEXT-Spalten), oder wenn die Tabelle mit

der Tabellenoption ROW_FORMAT=DYNAMIC

angelegt wurde.

Das dynamische Format ist ein wenig komplizierter als das statische, da jede Zeile einen Header mit einer Längenangabe besitzt. Eine Zeile kann fragmentiert (an nicht-benachbarten Orten gespeichert) werden, wenn sie aufgrund eines Updates länger wird.

Mit OPTIMIZE TABLE oder myisamchk

-r lassen sich Tabellen defragmentieren. Wenn in

einer Tabelle, die auch Spalten variabler Länge besitzt,

Spalten mit festgelegter Länge vorliegen, die oft

angesprochen oder geändert werden, so empfiehlt es sich, die

Spalten mit variabler Länge in andere Tabellen auszulagern,

um Fragmentierung zu verhindern.

Kennzeichen von dynamischen Tabellen:

Alle String-Spalten sind dynamisch, außer jenen, deren Länge weniger als vier beträgt.

Vor jeder Zeile steht eine Bitmap, die für String-Spalten angibt, welche Spalten den leeren String enthalten, und für numerische Spalten, welche Spalten den Wert null enthalten. Beachten Sie, dass dies keine Spalten mit

NULL-Werten einbezieht. Wenn eine String-Spalte nach dem Entfernen angehängter Leerzeichen die Länge null hat oder eine numerischen Spalte den Wert Null hat, wird sie in der Bitmap markiert und nicht auf der Festplatte gespeichert. Nicht-leere Strings werden mit einem Längen-Byte plus dem String-Inhalt gespeichert.Sie benötigen normalerweise weniger Festplattenplatz als Festlängen-Tabellen.

Jede Zeile belegt nur so viel Platz wie nötig. Doch wenn eine Zeile wächst, wird sie aufgespalten, was zu Fragmentierung führt. Wenn Sie zum Beispiel eine Zeile mit Daten aktualisieren, die ihre Länge anwachsen lassen, so wird sie fragmentiert. In diesem Fall kann es erforderlich sein, gelegentlich

OPTIMIZE TABLEoder myisamchk -r auszuführen, um die Leistung zu verbessern. myisamchk -ei kann Ihnen Statistikdaten zu Ihrer Tabelle liefern.Sie sind nach einem Absturz schwerer zu rekonstruieren als Tabellen fester Länge, da die Zeilen unter Umständen in viele Stücke fragmentiert sind und Links (Fragmente) verlorengegangen sein könnten.

Die erwartete Zeilenlänge für dynamische Zeilen wird mit folgendem Ausdruck berechnet:

3 + (

number of columns+ 7) / 8 + (number of char columns) + (packed size of numeric columns) + (length of strings) + (number of NULL columns+ 7) / 8Für jeden Link kommen 6 Bytes hinzu. Eine dynamische Zeile wird immer dann verknüpft (verlinkt), wenn ein Update sie verlängert. Da jeder neue Link mindestens 20 Bytes hat, passt die nächste Verlängerung wahrscheinlich noch in denselben Link mit hinein. Wenn nicht, wird ein neuer Link angelegt. Die Anzahl der Links lässt sich mit myisamchk -ed feststellen. Alle Links können mit

OPTIMIZE TABLEoder myisamchk -r entfernt werden.

Das komprimierte Speicherformat ist ein nur-lesbares Format, das mit myisampack angelegt wird. Komprimierte Tabellen lassen sich mit myisamchk auch wieder dekomprimieren.

Kennzeichen von komprimierten Tabellen:

Sie belegen sehr wenig Platz auf der Festplatte. Dadurch wird der Speicherverbrauch minimiert, was bei der Verwendung langsamer Speichermedien (zum Beispiel CD-ROMs) praktisch ist.

Da jede Zeile separat komprimiert wird, funktioniert der Zugriff mit geringem Aufwand. Der Header für eine Zeile belegt ein bis drei Bytes, abhängig von der längsten Zeile der Tabelle. Jede Spalte wird anders komprimiert und normalerweise gibt es für jede Spalte einen unterschiedlichen Huffman-Baum. Einige der Kompressionsarten sind:

Suffix-Kompression (Komprimierung von Leerzeichen am Ende).

Präfix-Kompression (Komprimierung von Leerzeichen am Anfang).

Zahlen mit dem Wert Null werden in einem Bit gespeichert.

Wenn Werte in einer Integerspalte einen kleinen Wertebereich haben, wird die Spalte im kleinstmöglichen Typ gespeichert. So kann zum Beispiel eine

BIGINT-Spalte (acht Bytes) alsTINYINT-Spalte (ein Byte) gespeichert werden, wenn alle ihre Werte zwischen-128und127betragen.Hat eine Spalte nur eine kleine Menge möglicher Werte, wird ihr Datentyp in eine

ENUMkonvertiert.Eine Spalte kann eine beliebige Kombination der oben beschriebenen Komprimierungen verwenden.

Kann für Spalten fester oder dynamischer Länge verwendet werden.

Zwar wurde das von MySQL für die Datenspeicherung genutzte Dateiformat ausführlich getestet, aber es können immer Umstände auftreten, durch die Datenbanktabellen beschädigt werden. Im Folgenden wird erklärt, wie es dazu kommt und wie man damit umgeht.

Obwohl das Tabellenformat MyISAM sehr

zuverlässig ist (alle Änderungen, die eine SQL-Anweisung an

einer Tabelle vornimmt, werden geschrieben, ehe die Anweisung

zurückkehrt), können dennoch unter folgenden Umständen

Tabellen beschädigt werden:

Der mysqld-Prozess wird mitten in einem Schreibvorgang abgebrochen.

Der Computer wird unerwartet heruntergefahren (zum Beispiel ausgeschaltet).

Ein Hardware-Versagen.

Während eine Tabelle gerade vom Server modifiziert wird, ändern Sie dieselbe Tabelle mit einem externen Programm (zum Beispiel myisamchk).

Ein Software-Bug im Code von MySQL oder

MyISAM.

Die folgenden Symptome sind typisch für eine beschädigte Tabelle:

Beim Auswählen von Daten aus der Tabelle bekommen Sie folgende Fehlermeldung:

Incorrect key file for table: '...'. Try to repair it

Anfragen können Zeilen in der Tabelle nicht finden oder liefern unvollständige Ergebnisse zurück.

Mit der CHECK TABLE-Anweisung können Sie

die Integrität einer MyISAM-Tabelle

überprüfen und mit REPAIR TABLE können

Sie sie reparieren, wenn sie beschädigt ist. Wenn

mysqld nicht läuft, können Sie eine

Tabelle auch mit dem Befehlmyisamchk

prüfen oder reparieren Siehe hierzu auch

Abschnitt 13.5.2.3, „CHECK TABLE“, Abschnitt 13.5.2.6, „REPAIR TABLE“

und Abschnitt 8.2, „myisamchk — Hilfsprogramm für die Tabellenwartung von MyISAM“.

Werden Ihre Tabellen häufig beschädigt, so sollten Sie nach

den Ursachen forschen. Am wichtigsten ist es, festzustellen,

ob die Tabelle infolge eines Server-Absturzes beschädigt

wurde. Das können Sie leicht daran erkennen, dass im

Fehler-Log eine restarted mysqld-Nachricht

jüngeren Datums gespeichert ist. Wenn ja, dann wurde die

Tabelle wahrscheinlich durch den Absturz des Servers

beschädigt. Andernfalls kann der Schaden auch im normalen

Betrieb aufgetreten sein. Das wäre dann ein Bug. Versuchen

Sie in diesem Fall, einen reproduzierbaren Testfall zu

erstellen, der das Problem demonstriert. Siehe auch

Abschnitt A.4.2, „Was zu tun ist, wenn MySQL andauernd abstürzt“ und

Abschnitt E.1.6, „Erzeugen eines Testfalls, wenn Sie Tabellenbeschädigung feststellen“.

Jede MyISAM-Indexdatei

(.MYI-Datei) besitzt im Header einen

Zähler, an dem sich erkennen lässt, ob eine Tabelle

ordnungsgemäß geschlossen wurde. Liefert CHECK

TABLE oder myisamchk folgende

Warnung, so bedeutet dies, dass der Zähler nicht mehr

synchron läuft:

clients are using or haven't closed the table properly

Diese Warnung bedeutet zwar nicht unbedingt, dass die Tabelle beschädigt ist, aber Sie sollten zumindest eine Überprüfung vornehmen.

Der Zähler funktioniert folgendermaßen:

Wenn eine Tabelle in MySQL zum ersten Mal geändert wird, wird ein Zähler im Header der Indexdateien inkrementiert.

Bei nachfolgenden Änderungen bleibt der Zähler gleich.

Wenn die letzte Instanz einer Tabelle geschlossen wird (wegen einer

FLUSH TABLES-Operation oder weil im Tabellen-Cache kein Platz mehr ist), wird der Zähler dekrementiert, wenn die Tabelle an irgendeinem Punkt geändert wurde.Wenn Sie die Tabelle reparieren oder prüfen und für gut befinden, wird der Zähler wieder auf Null zurückgesetzt.

Um Abstimmungsprobleme mit anderen Prozessen zu verhindern, welche die Tabelle ebenfalls überprüfen, wird der Zähler beim Schließen nicht dekrementiert, wenn er den Wert null hatte.

Anders ausgedrückt: Der Zähler kann unter folgenden Bedingungen nicht mehr synchron sein:

Eine

MyISAM-Tabelle wird ohne vorherigesLOCK TABLESundFLUSH TABLESkopiert.MySQL ist zwischen einer Änderung und dem endgültigen Schließen der Tabelle abgestürzt. (Beachten Sie, dass auch in diesem Fall die Tabelle immer noch in Ordnung sein kann, da MySQL zwischen zwei Anweisungen immer alles schreibt.)

Eine Tabelle wurde von myisamchk --recover oder myisamchk --update-state geändert, während sie gleichzeitig von mysqld benutzt wurde.

Mehrere mysqld-Server benutzen die Tabelle und einer von ihnen hat

REPAIR TABLEoderCHECK TABLEauf ihr ausgeführt, während die anderen Server gerade auf sie zugriffen. In diesem Fall ist die Verwendung vonCHECK TABLEsicher, obwohl Sie vielleicht von anderen Servern eine Warnung bekommen.REPAIR TABLEsollten Sie allerdings vermeiden, denn wenn ein Server die Datendatei durch eine neue ersetzt, können die anderen Server dies nicht wissen.Normalerweise sollte man ein Data Directory nicht mit mehreren Servern gemeinsam nutzen. Weitere Hinweise finden Sie unter Abschnitt 5.13, „Mehrere MySQL-Server auf derselben Maschine laufen lassen“.

- 14.2.1. Überblick über InnoDB-Tabellen

- 14.2.2. Kontaktinformationen

- 14.2.3. Konfiguration

- 14.2.4.

InnoDB: Startoptionen und Systemvariablen - 14.2.5. InnoDB-Tablespace erzeugen

- 14.2.6.

InnoDB-Tabellen erzeugen - 14.2.7. Hinzufügen und Entfernen von InnoDB-Daten- und -Logdateien

- 14.2.8. Sichern und Wiederherstellen einer

InnoDB-Datenbank - 14.2.9. Eine InnoDB-Datenbank auf eine andere Maschine verschieben

- 14.2.10. InnoDB-Transaktionsmodell

- 14.2.11. Tipps zur Leistungssteigerung

- 14.2.12. Implementierung der Multiversionierung

- 14.2.13. Tabellen- und Indexstrukturen

- 14.2.14. Verwaltung von Speicherplatz für Dateien und von Festplattenein- und -ausgaben

- 14.2.15.

InnoDB-Fehlerbehandlung - 14.2.16. Beschränkungen von

InnoDB-Tabellen - 14.2.17.

InnoDB-Troubleshooting

Mit InnoDB verfügt MySQL über eine

transaktionssichere (ACID-konforme)

Speicher-Engine mit Commit-, Rollback- und

Datenwiederherstellungsfähigkeiten. InnoDB

beherrscht sowohl Zeilensperren als auch, ähnlich wie Oracle,

eine konsistente Leseoperation ohne Sperren für

SELECT-Anweisungen. Diese Features verbessern

die Mehrbenutzertauglichkeit und die Leistung.

InnoDB benötigt keine Sperreneskalation da

Zeilensperren sehr wenig Platz beanspruchen. Außerdem

unterstützt InnoDB die FOREIGN

KEY-Constraints. Sie können

InnoDB-Tabellen nach Belieben mit Tabellen aus

anderen MySQL-Speicher-Engines mischen, sogar in ein- und

derselben Anweisung.

InnoDB wurde für maximale Leistung bei der

Verarbeitung großer Datenmengen ausgelegt. Es gibt wohl keine

andere festplattengestützte Speicher-Engine für relationale

Datenbanken, die so effizient mit der CPU umgeht.

Die voll in den MySQL-Server integrierte

InnoDB-Speicher-Engine hat ihren eigenen

Bufferpool zur Speicherung von Daten und Indizes im Hauptspeicher.

InnoDB speichert ihre Tabellen und Indizes in

einem Tablespace, der aus mehreren Dateien (oder

Festplattenpartitionen) bestehen kann. Darin unterscheidet sie

sich beispielsweise von MyISAM, wo jede Tabelle

in separaten Dateien untergebracht wird.

InnoDB-Tabellen können beliebig groß sein,

selbst auf Betriebssystemen, deren Dateigröße auf 2GB

beschränkt ist.

InnoDB ist standardmäßig in

Binärdistributionen enthalten. Der Windows Essentials-Installer

macht InnoDB auf Windows zur

Standard-Speicher-Engine für MySQL.

InnoDB wird in einer Vielzahl großer

Produktionsdatenbanken eingesetzt, die hohe Anforderungen an die

Leistung stellen. Die bekannte Internet-Newssite Slashdot.org

läuft mit InnoDB. Mytrix speichert mehr als

1TB Daten in InnoDB und eine andere Site

verarbeitet durchschnittlich 800 Inserts/Updates pro Sekunde auf

InnoDB.

InnoDB unterliegt derselben GNU GPL License

Version 2 (von Juni 1991) wie MySQL. Weitere Informationen über

MySQL-Lizenzen finden Sie unter

http://www.mysql.com/company/legal/licensing/.

Ein spezielles

InnoDB-Forum finden Sie unter http://forums.mysql.com/list.php?22.

Mit Innobase Oy, dem Produzenten der

InnoDB-Engine können Sie wie folgt Kontakt

aufnehmen:

Web site: http://www.innodb.com/

Email: <sales@innodb.com>

Phone: +358-9-6969 3250 (office)

+358-40-5617367 (mobile)

Innobase Oy Inc.

World Trade Center Helsinki

Aleksanterinkatu 17

P.O.Box 800

00101 Helsinki

Finland

Die Speicher-Engine InnoDB ist nach

Voreinstellung aktiv. Wenn Sie keine

InnoDB-Tabellen verwenden möchten, setzen Sie

die Option skip-innodb in Ihre

MySQL-Optionsdatei.

Hinweis: Mit

InnoDB verfügt MySQL über eine

transaktionssichere (ACID-konforme)

Speicher-Engine mit Commit-, Rollback- und

Datenwiederherstellungsfähigkeiten. Diese

Fähigkeiten stehen jedoch nur dann zur Verfügung, wenn auch das

zugrunde liegende Betriebssystem und die Hardware

vorschriftsgemäß arbeiten.. Viele Betriebssysteme

oder Festplatten-Subsysteme verzögern Schreiboperationen oder

ordnen sie anders an, um die Leistung zu verbessern. Auf manchen

Betriebssystemen kann sogar der Systemaufruf selbst, der

eigentlich warten sollte, bis alle noch ungespeicherten Daten

einer Datei auf die Platte zurückgeschrieben wurden —

fsync() — bereits zurückkehren, ehe die

Daten in einen dauerhaften Speicher geschrieben wurden. So kann

zum Beispiel ein Betriebssystemabsturz oder ein Stromausfall

Daten, die gerade erst committet wurden, zerstören, oder im

schlimmsten Fall sogar die Datenbank schädigen, indem

Schreiboperationen in die verkehrte Reihenfolge gestellt werden.

Wenn Ihnen an der Integrität Ihrer Daten etwas liegt, sollten Sie

das Verhalten bei Stromausfall testen, ehe Sie etwas in die

Produktionsumgebung einführen. Auf Mac OS X 10.3 und höher

verwendet InnoDB eine spezielle

fcntl()-Methode, um Dateien auf die Festplatte

zurückzuschreiben. Unter Linux empfiehlt es sich, den

Write-Back-Cache zu deaktivieren.

Auf ATAPI-Festplatten kann es funktionieren, mit einem Befehl wie

hdparm -W0 /dev/hda den Write-Back-Cache zu

deaktivieren. Vorsicht! Manche Treiber oder

Festplattencontroller sind nicht in der Lage, den Write-Back-Cache

zu deaktivieren.

Zwei wichtige, von InnoDB verwalteten

Festplattenressourcen sind die Tablespace-Datendateien und die

Logdateien.

Hinweis: Wenn Sie

Konfigurationsoptionen für InnoDB angeben,

erzeugt MySQL eine sich selbst erweiternde, 10MB große Datendatei

namens ibdata1 und zwei 5MB große Logdateien

namens ib_logfile0 und

ib_logfile1 im MySQL Data Directory. Um eine

gute Performance zu erzielen, sollten Sie explizit die in den

folgenden Beispielen erwähnten

InnoDB-Parameter setzen, allerdings natürlich

angepasst an Ihre Hardware und Systemanforderungen.

Die folgenden Beispiele haben nur repräsentativen Charakter. In

Abschnitt 14.2.4, „InnoDB: Startoptionen und Systemvariablen“ erfahren Sie mehr über die

Konfigurationsparameter für InnoDB.

Die InnoDB-Tablespace-Dateien richten Sie ein,

indem Sie die Option innodb_data_file_path im

[mysqld]-Abschnitt der Optionsdatei

my.cnf einstellen. Auf Windows verwenden Sie

stattdessen my.ini. Der

innodb_data_file_path sollte eine Liste mit

einer oder mehreren Datendatei-Spezifikationen sein. Mehrere

Datendateien werden durch Semikola

(‘;’) getrennt:

innodb_data_file_path=datafile_spec1[;datafile_spec2]...

Eine Einstellung, die explizit einen Tablespace mit den Standardmerkmalen anlegt, wäre beispielsweise:

[mysqld] innodb_data_file_path=ibdata1:10M:autoextend

Diese Einstellung konfiguriert eine einzige 10MB große Datendatei

namens ibdata1, die sich selbsttätig

erweitert. Da kein Verzeichnis vorgegeben ist, legt

InnoDB sie im MySQL Data Directory an.

Größen geben Sie an, indem Sie das Suffix M

für MB oder G für GB verwenden.

Ein Tablespace mit einer 50MB großen Datendatei fester Größe

namens ibdata1 und einer 50MB großen,

selbsterweiternden Datei namens ibdata2 im

Data Directory kann folgendermaßen konfiguriert werden:

[mysqld] innodb_data_file_path=ibdata1:50M;ibdata2:50M:autoextend

Zur vollständigen Syntax einer Datendateispezifikation gehören Dateiname, Größe und mehrere optionale Attribute:

file_name:file_size[:autoextend[:max:max_file_size]]

autoextend und die folgenden Attribute können

nur für die letzte Datendatei auf der Zeile

innodb_data_file_path verwendet werden.

Wenn Sie die Option autoextend für die letzte

Datendatei angeben, erweitert InnoDB diese

Datei, sobald sie im Tablespace nicht mehr genug freien Platz hat,

in Inkrementierungsschritten, die auf 8MB voreingestellt sind.

Diese Einstellung kann in der Systemvariablen

innodb_autoextend_increment geändert werden.

Wenn die Platte vollläuft, müssen Sie eine andere Datendatei oder Festplatte hinzufügen. Eine Anleitung zur Rekonfiguration vorhandener Tablespaces finden Sie in Abschnitt 14.2.7, „Hinzufügen und Entfernen von InnoDB-Daten- und -Logdateien“.

Da InnoDB die maximale Dateigröße des

Dateisystems nicht kennt, müssen Sie aufpassen, wenn Ihr

Dateisystem nur einen relativ kleinen Wert wie etwa 2GB zulässt.

Eine Maximalgröße für eine selbsterweiternde Datendatei geben

Sie mit dem Attribut max an. In der folgenden

Konfiguration kann ibdata1 auf bis zu 500MB

anwachsen:

[mysqld] innodb_data_file_path=ibdata1:10M:autoextend:max:500M

InnoDB legt Ttablespace-Dateien standardmäßig

im MySQL Data Directory an. Um ein anderes Verzeichnis anzugeben,

verwenden Sie die Option innodb_data_home_dir.

Wenn sie zum Beispiel zwei Dateien namens

ibdata1 und ibdata2 im

Verzeichnis /ibdata anlegen möchten, müssen

Sie InnoDB wie folgt konfigurieren:

[mysqld] innodb_data_home_dir = /ibdata innodb_data_file_path=ibdata1:50M;ibdata2:50M:autoextend

Hinweis: Da

InnoDB keine Verzeichnisse erstellt, müssen

Sie dafür sorgen, dass /ibdata existiert,

ehe Sie den Server starten. Das gilt auch für

Logdateiverzeichnisse, die Sie konfigurieren. Mit dem Unix- oder

DOS-Befehl mkdir können Sie alle

erforderlichen Verzeichnisse anlegen.

InnoDB bildet Verzeichnispfade für

Datendateien, indem es den Wert von

innodb_data_home_dir mit dem Namen der

Datendatei verkettet, und wenn nötig ein Pfadtrennzeichen

(Schrägstrich oder Backslash) zwischen die Werte setzt. Wenn die

Option innodb_data_home_dir in

my.cnf gar nicht auftaucht, ist der

Standardwert das „Punkt“-Verzeichnis

./, also das MySQL Data Directory. (Der

MySQL-Server macht das Data Directory zum aktuellen

Arbeitsverzeichnis, wenn er seine Arbeit aufnimmt.)

Wenn Sie innodb_data_home_dir als leeren String

angeben, können Sie absolute Pfade für die Datendateien angeben,

die im Wert von innodb_data_file_path

aufgeführt sind. Das folgende Beispiel ist äquivalent zu dem

vorherigen:

[mysqld] innodb_data_home_dir = innodb_data_file_path=/ibdata/ibdata1:50M;/ibdata/ibdata2:50M:autoextend

Ein einfaches

my.cnf-Beispiel. Angenommen, Sie

haben einen Computer mit 128MB Arbeitsspeicher und einer

Festplatte. Das folgende Beispiel zeigt mögliche

Konfigurationsparameter in my.cnf oder

my.ini für InnoDB,

einschließlich des autoextend-Attributs. Das

Beispiel passt zu den meisten Unix- und Windows-Benutzern, die

ihre InnoDB-Datendateien und -Logdateien nicht

auf mehrere Festplatten verteilen möchten. Es legt eine

selbsterweiternde Datendatei namens ibdata1

und zwei InnoDB-Logdateien namens

ib_logfile0 und

ib_logfile1 im MySQL Data Directory an.

Außerdem wird die kleine, archivierte

InnoDB-Logdatei

ib_arch_log_0000000000, die

InnoDB automatisch erstellt, ins Data Directory

gespeichert.

[mysqld] # Hier können Sie Ihre übrigen MySQL-Server-Optionen angeben # ... # Datendateien müssen Daten und Indizes speichern können. # Achten Sie auf ausreichend freien Plattenplatz. innodb_data_file_path = ibdata1:10M:autoextend # # Bufferpool-Größe wird auf 50-80% vom Arbeitsspeicher eingestellt innodb_buffer_pool_size=70M innodb_additional_mem_pool_size=10M # # Logdateigröße wird auf 25% der Bufferpool-Größe eingestellt innodb_log_file_size=20M innodb_log_buffer_size=8M # innodb_flush_log_at_trx_commit=1

Achten Sie darauf, dass der MySQL-Server die richtigen Berechtigungen hat, um Dateien im Data Directory anlegen zu können. Generell benötigt der Server Zugriffsrecht auf jedes Verzeichnis, in dem er Daten- oder Logdateien anlegen soll.

Beachten Sie, dass Datendateien in manchen Dateisystemen höchstens 2GB groß sein dürfen. Die kombinierte Größe aller Logdateien muss unter 4GB liegen und die kombinierte Größe der Datendateien mindestens 10MB betragen.

Wenn Sie zum ersten Mal einen InnoDB-Tablespace

anlegen, starten Sie den MySQL-Server am besten von der

Kommandozeile. Da InnoDB dann Informationen

über die Datenbankerstellung auf dem Bildschirm ausgibt, können

Sie sehen, was geschieht. Wenn beispielsweise auf Windows

mysqld-max im Verzeichnis C:\Program

Files\MySQL\MySQL Server 5.1\bin liegt,

können Sie folgendermaßen starten:

C:\> "C:\Program Files\MySQL\MySQL Server 5.1\bin\mysqld-max" --console

Wenn sie keine Serverausgabe an den Bildschirm schicken, müssen

Sie im Fehlerlog nachschauen, welche Meldungen

InnoDB beim Hochfahren ausgibt.

Unter Abschnitt 14.2.5, „InnoDB-Tablespace erzeugen“ sehen Sie ein Beispiel dafür,

welche Informationen InnoDB anzeigt.

Die InnoDB-Optionen können Sie in die

[mysqld]-Gruppe einer beliebigen Optionsdatei

legen, die Ihr Server beim Hochfahren liest. Speicherorte für

Optionsdateien werden in Abschnitt 4.3.2, „my.cnf-Optionsdateien“

beschrieben.

Wenn Sie MySQL auf Windows mit dem Installations- und

Konfigurationsassistenten installiert haben, liegen die Optionen

in der my.ini-Datei in Ihrem

MySQL-Installationsverzeichnis. Siehe

Abschnitt 2.3.5.14, „Speicherort der Datei my.ini“.

Wenn Ihr PC einen Bootloader nutzt und C:

nicht das Bootverzeichnis ist, haben Sie keine andere

Möglichkeit, als die my.ini-Datei in Ihrem

Windows-Verzeichnis zu benutzen (in der Regel

C:\WINDOWS oder

C:\WINNT). Verwenden Sie den Befehl

SET auf der Kommandozeile eines

Konsolenfensters, um den Wert von WINDIR

auszugeben:

C:\> SET WINDIR

windir=C:\WINDOWS

Wenn Sie sicherstellen möchten, dass

mysqld-Optionen nur aus einer bestimmten Datei

liest, verwenden Sie --defaults-option beim

Serverstart als erste Option auf der Kommandozeile:

mysqld --defaults-file=your_path_to_my_cnf

Ein

fortgeschrittenesmy.cnf-Beispiel.

Angenommen, Sie haben einen Linux-Computer mit 2GB RAM und drei

60GB-Festplatten mit den Verzeichnispfaden /,

/dr2 und /dr3. Das

folgende Beispiel zeigt, welche Konfigurationsparameter man in

my.cnf für InnoDB setzen

könnte.

[mysqld] # Hier können Sie Ihre übrigen MySQL-Server-Optionen angeben # ... innodb_data_home_dir = # # Datendateien müssen Daten und Indizes speichern können. innodb_data_file_path = /ibdata/ibdata1:2000M;/dr2/ibdata/ibdata2:2000M:autoextend # # Setzen Sie die Bufferpool-Größe auf 50-80% des Arbeitsspeichers, # aber achten Sie darauf, dass für Linux x86 die gesamte Speichernutzung < 2GB ist. innodb_buffer_pool_size=1G innodb_additional_mem_pool_size=20M innodb_log_group_home_dir = /dr3/iblogs # innodb_log_files_in_group = 2 # # Setzen Sie die Logdateigröße auf circa 25% der Bufferpool-Größe innodb_log_file_size=250M innodb_log_buffer_size=8M # innodb_flush_log_at_trx_commit=1 innodb_lock_wait_timeout=50 # # Kommentieren Sie die nächsten Zeilen aus, wenn Sie sie nutzen möchten #innodb_thread_concurrency=5

In manchen Fällen steigt die Datenbank-Performance, wenn nicht

alle Daten auf derselben physikalischen Platte liegen. Oft ist es

gut für die Performance, wenn die Logdateien auf einer anderen

Festplatte liegen. Das Beispiel zeigt, wie das geht: Es speichert

zwei Dateien auf verschiedenen Festplatten und legt die Logdateien

auf eine dritte Platte. InnoDB füllt den

Tablespace beginnend mit der ersten Datendatei. Für einen

schnelleren Zugriff können Sie auch rohe Festplattenpartitionen

(Raw Devices) als InnoDB-Datendateien

verwenden. Siehe Abschnitt 14.2.3.2, „Verwendung von Raw Devices für den Shared Tablespace“.

Warnung: Auf 32-Bit GNU/Linux x86

dürfen Sie die Arbeitsspeichernutzung nicht zu hoch einstellen.

Wenn glibc den Prozess-Heap über die

Thread-Stacks hinauswachsen lässt, stürzt der Server ab. Wenn

der Wert des folgenden Ausdrucks 2GB erreicht oder übersteigt,

ist Gefahr in Verzug:

innodb_buffer_pool_size + key_buffer_size + max_connections*(sort_buffer_size+read_buffer_size+binlog_cache_size) + max_connections*2MB

Jeder Thread benutzt einen Stack (oft 2MB, aber in den Binaries

von MySQL AB nur 256KB) und im schlimmsten Fall auch

sort_buffer_size + read_buffer_size

zusätzlichen Arbeitsspeicher.

Indem Sie MySQL selbst kompilieren, können Sie bis zu 64GB

physikalischen Speicher in 32-Bit Windows verwenden. Siehe

Beschreibung von innodb_buffer_pool_awe_mem_mb

in Abschnitt 14.2.4, „InnoDB: Startoptionen und Systemvariablen“.

Wie werden die anderen mysqld-Serverparameter eingestellt? Die folgenden Werte sind typisch und eignen sich für die meisten Nutzer:

[mysqld]

skip-external-locking

max_connections=200

read_buffer_size=1M

sort_buffer_size=1M

#

# Setzen Sie key_buffer auf 5 - 50% Ihres Arbeitsspeichers, je nachdem, wie

# oft Sie MyISAM-Tabellen benutzen, aber behalten Sie key_buffer_size + InnoDB

# buffer pool size < 80% Ihres Arbeitsspeichers

key_buffer_size=value

Sie können jede InnoDB-Tabelle und ihre

Indizes in ihrer eigenen Datei speichern. Dieses Feature nennt

man „Multi-Tablespaces“ da im Endeffekt jede

Tabelle ihren eigenen Tablespace bekommt.

Multi-Tablespaces sind praktisch für Benutzer, die bestimmte

Tabellen auf separate physikalische Platten verlagern oder

Backups einzelner Tabellen rasch wiederherstellen möchten, ohne

die Arbeit mit den übrigen InnoDB-Tabellen

zu unterbrechen.

Aktivieren Sie Multi-Tablespaces mit folgender Zeile im

[mysqld]-Abschnitt von

my.cnf:

[mysqld] innodb_file_per_table

Nach dem Server-Neustart speichert InnoDB

jede neu erzeugte Tabelle in einer eigenen Datei

tbl_name.ibdMyISAM-Speicher-Engine, doch diese spaltet

die Tabellen in eine Datendatei

tbl_name.MYDtbl_name.MYIInnoDB werden Daten und Indizes gemeinsam

in der.ibd-Datei gespeichert. Die

tbl_name.frm

Wenn Sie die innodb_file_per_table-Zeile aus

my.cnf löschen und den Server neu starten,

erzeugt InnoDB die Tabellen wieder in Shared

Tablespace-Dateien.

innodb_file_per_table wirkt sich nur auf eine

einzelne Tabellenerzeugung aus, und beeinflusst nicht den

Zugriff auf bestehende Tabellen. Wenn Sie den Server mit dieser

Option starten, werden neue Tabellen mit

.ibd-Dateien angelegt, aber alte liegen

immer noch im Shared Tablespace. Entfernen Sie die Option wieder

und starten dann den Server neu, werden die neuen Tabellen im

Shared Tablespace angelegt, aber Tabellen, die mit

Multi-Tablespaces angelegt wurden, bleiben weiterhin

zugänglich.

InnoDB benötigt immer den Shared Tablespace,

da es sein internes Data Dictionary und seine Undo-Logs dort

speichert. Die .ibd-Dateien reichen

InnoDB zum Funktionieren nicht aus.

Hinweis: Sie können

.ibd-Dateien genau wie

MyISAM-Tabellendateien nach Belieben zwischen

Datenbankverzeichnissen hin- und herschieben, weil die im Shared

Tablespace von InnoDB gespeicherte

Tabellendefinition den Datenbanknamen enthält und weil

InnoDB die Konsistenz von Transaktions-IDs

und Lognummern beibehalten muss.

Um eine .ibd-Datei und die zugehörige

Tabelle von einer Datenbank in eine andere zu verlagern,

verwenden Sie eine RENAME TABLE-Anweisung:

RENAME TABLEdb1.tbl_nameTOdb2.tbl_name;

Wenn Sie über ein „sauberes“ Backup einer

.ibd-Datei verfügen, können Sie diese in

ihrer angestammten MySQL-Installation folgendermaßen

wiederherstellen:

Geben Sie folgende

ALTER TABLE-Anweisung:ALTER TABLE

tbl_nameDISCARD TABLESPACE;Vorsicht: Diese Anweisung löscht die aktuelle

.ibd-Datei.Speichern Sie die

.ibd-Backup-Datei zurück in das richtige Datenbankverzeichnis.Geben Sie folgende

ALTER TABLE-Anweisung:ALTER TABLE

tbl_nameIMPORT TABLESPACE;

Ein „sauberes“ Backup einer

.ibd-Datei bedeutet in diesem Zusammenhang:

Keine schwebenden Transaktionen in der

.ibd-Datei.Keine noch nicht zusammengeführten Insert-Puffer-Einträge in der

.ibd-Datei.Purge hat alle zum Löschen vorgemerkten Indexeinträge aus der

.ibd-Datei entfernt.mysqld hat alle geänderten Seiten der

.ibd-Datei aus dem Bufferpool in die Datei zurückgeschrieben.

Mit folgender Methode können Sie eine saubere

.ibd-Backup-Datei anlegen:

Beenden Sie alle Aktivitäten des mysqld-Servers und schreiben Sie alle Transaktionen fest.

Warten Sie, bis

SHOW ENGINE INNODB STATUSanzeigt, dass keine Transaktionen mehr in der Datenbank aktiv sind und der Status des Haupt-Threads vonInnoDBden WertWaiting for server activityangenommen hat. Dann können Sie die.ibd-Datei kopieren.

Eine andere Möglichkeit, an eine saubere Kopie einer

.ibd-Datei zu kommen, ist die Verwendung

eines kommerziellen InnoDB Hot Backup-Tools:

Legen Sie mit InnoDB Hot Backup ein Backup der

InnoDB-Installation an.Starten Sie einen zweiten mysqld-Server auf dem Backup und lassen Sie ihn die

.ibd-Dateien im Backup säubern.

Sie können auch rohe Festplattenpartitionen für die Datendateien im Shared Tablespace verwenden. So können sie ungepufferte E/A-Zugriffe ohne Dateisystem-Overhead auf Windows und einigen Unix-Systemen implementieren und die Performance dadurch steigern.

Wenn Sie eine neue Datendatei anlegen, müssen Sie in

innodb_data_file_path das Schlüsselwort

newraw direkt hinter die Größe der

Datendatei setzen. Die Partition muss mindestens die angegebene

Größe haben. Beachten Sie, dass 1MB in

InnoDB 1024 × 1024 Bytes sind, während

1MB in Festplattenspezifikationen normalerweise 1.000.000 Bytes

bedeutet.

[mysqld] innodb_data_home_dir= innodb_data_file_path=/dev/hdd1:3Gnewraw;/dev/hdd2:2Gnewraw

Wenn Sie den Server das nächste Mal starten, bemerkt

InnoDB das Schlüsselwort

newraw und initialisiert die neue Partition.

Sie dürfen jetzt aber noch keine

InnoDB-Tabellen ändern oder anlegen, sonst

reinitialisiert InnoDB beim nächsten

Serverstart die Partition und Ihre Änderungen gehen verloren.

(Als Sicherheitsmaßnahme hindert InnoDB die

Benutzer daran, irgendwelche Daten zu ändern, wenn eine

Partition mit newraw definiert wurde.)

Nachdem InnoDB die neue Partition

initialisiert hat, halten Sie den Server an und ändern

newraw in der Datendateispezifikation in

raw um:

[mysqld] innodb_data_home_dir= innodb_data_file_path=/dev/hdd1:5Graw;/dev/hdd2:2Graw

Wenn Sie nun den Server erneut starten, erlaubt

InnoDB auch Änderungen.

Auf Windows können Sie eine Festplattenpartition folgendermaßen als Datendatei zuweisen:

[mysqld] innodb_data_home_dir= innodb_data_file_path=//./D::10Gnewraw

Das //./ entspricht beim Zugriff auf

physikalische Platten der Windows-Syntax

\\.\.

Wenn Sie rohe Festplattenpartitionen benutzen, achten Sie bitte darauf, dass ihre Berechtigungseinstellungen dem vom MySQL-Server benutzten Konto auch Lese- und Schreiboperationen gestatten.

Dieser Abschnitt beschreibt die Befehlsoptionen und

Systemvariablen für InnoDB. Systemvariablen,

die true oder false sein können, werden beim Serverstart entweder

durch Nennung ihres Namens aktiviert oder mit dem Präfix

skip- deaktiviert. Um beispielsweise

InnoDB-Prüfsummen ein- oder auszuschalten,

verwenden Sie --innodb_checksums oder

--skip-innodb_checksums auf der Kommandozeile,

oder innodb_checksums oder

skip-innodb_checksums in einer Optionsdatei.

Systemvariablen, die einen numerischen Wert annehmen, können als

--

auf der Kommandozeile oder als

var_name=valuevar_name=value

InnoDB-Befehlsoptionen:

--innodbAktiviert die

InnoDB-Speicher-Engine, wenn der Server mitInnoDB-Unterstützung kompiliert wurde. Mit--skip-innodbkönnen SieInnoDBdeaktivieren.--innodb_status_fileVeranlasst

InnoDB, eine Datei namens<datadir>/innodb_status.<pid>InnoDBschreibt in regelmäßigen Abständen die Ausgabe vonSHOW ENGINE INNODB STATUSin diese Datei.

InnoDB-Systemvariablen:

innodb_additional_mem_pool_sizeDie Größe des von

InnoDBzum Speichern von Data Dictionary-Informationen und anderen internen Datenstrukturen verwendeten Arbeitsspeicherpools in Bytes. Je mehr Tabellen Ihre Anwendung hat, umso mehr Arbeitsspeicher müssen Sie hier zuweisen. WennInnoDBin diesem Pool der Speicher ausgeht, beginnt es, Arbeitsspeicher vom Betriebssystem abzuzweigen, und gibt Warnmeldungen in das MySQL-Fehlerlog aus. Der Standardwert beträgt 1MB.innodb_autoextend_incrementIn Inkrementen dieser Größe (in MB) wächst ein selbsterweiternder Tablespace, wenn er vollläuft. Der Standardwert beträgt 8.

innodb_buffer_pool_awe_mem_mbDie Größe des Bufferpools (in MB), wenn er im AWE-Speicher liegt. Dies gilt jedoch nur für 32-Bit Windows. Wenn Ihr 32-Bit Windows-Betriebssystem über die so genannten „Address Windowing Extensions“ mehr als 4GB Arbeitsspeichergröße unterstützt, können Sie den

InnoDB-Bufferpool im physikalischen AWE-Speicher mit dieser Variablen zuweisen. Der größtmögliche Wert der Variablen beträgt 63000. Ist er größer als 0, istinnodb_buffer_pool_sizedas Fenster im 32-Bit-Adressraum von mysqld, wobeiInnoDBdiesen AWE-Arbeitsspeicher abbildet. Ein guter Wert fürinnodb_buffer_pool_sizeist 500MB.Um den AWE-Speicher nutzen zu können, müssen Sie MySQL neu kompilieren. Welche Projekteinstellungen derzeit dazu erforderlich sind, entnehmen Sie bitte der Quelldatei

storage/innobase/os/os0proj.c.innodb_buffer_pool_sizeDie Größe des Arbeitsspeicherpuffers in Bytes, den

InnoDBzum Zwischenspeichern der Daten und Indizes seiner Tabellen benutzt. Je größer Sie diesen Wert einstellen, umso weniger Festplattenzugriffe sind für den Zugriff auf die Tabellendaten erforderlich. Für einen dedizierten Datenbankserver können Sie dies auf 80% des physikalischen Arbeitsspeichers heraufsetzen. Machen Sie ihn jedoch nicht zu groß, da ein Wettlauf um den physikalischen Speicher das Betriebssystem zum Paging veranlassen kann.innodb_checksumsInnoDBkann für alle von der Platte gelesenen Seiten eine Prüfsummenvalidierung verwenden, um eine zusätzliche Fehlertoleranz gegenüber Schäden an Hardware oder Datendateien zu gewährleisten. Diese Validierung ist standardmäßig eingeschaltet. Doch in einigen wenigen Fällen (zum Beispiel bei der Ausführung von Benchmarks) ist diese zusätzliche Sicherheitsvorkehrung überflüssig und kann mit--skip-innodb-checksumsdeaktiviert werden.innodb_commit_concurrencyDie Anzahl der Threads, die gleichzeitig committen können. Der Wert 0 schaltet die Nebenläufigkeitssteuerung aus.

innodb_concurrency_ticketsWie viele Threads gleichzeitig auf

InnoDBzugreifen können, hängt von der Einstellung derinnodb_thread_concurrency-Variablen ab. Ein Thread wird in eine Schlange gestellt, wenn er aufInnoDBzugreifen möchte und das Nebenläufigkeitslimit bereits erreicht ist. Wenn einem Thread der Eintritt inInnoDBerlaubt wird, bekommt eine Anzahl von „Freifahrscheine“, die der Anzahl derinnodb_concurrency_ticketsentspricht und kannInnoDBso lange nach Belieben betreten und verlassen, bis seine Freifahrscheine aufgebraucht sind. Danach wird der Thread wieder einer Prüfung unterzogen (und eventuell in die Schlange gestellt), wenn er das nächste Mal inInnoDBeintreten möchte.innodb_data_file_pathDie Pfade und Größen der einzelnen Datendateien. Der vollständige Verzeichnispfad zu den Datendateien entsteht, wenn

innodb_data_home_dirmit den einzelnen, hier angegebenen Pfaden verkettet wird. Die Dateigrößen werden in MB oder GB (1024MB) durch Anfügen vonModerGan den Größenwert angegeben. Die Summe der Dateigrößen muss mindestens 10MB betragen. Wenn Sie keineninnodb_data_file_pathangeben, wird standardmäßig eine einzige, selbsterweiternde, 10MB große Datendatei namensibdata1erzeugt. Wie groß die einzelnen Dateien werden können, entscheidet Ihr Betriebssystem. Auf Systemen, die große Dateien unterstützen, können Sie die Dateigröße auf mehr als 4GB setzen. Sie können auch rohe Festplattenpartitionen als Datendateien einsetzen. Siehe Abschnitt 14.2.3.2, „Verwendung von Raw Devices für den Shared Tablespace“.innodb_data_home_dirDer gemeinsame Teil des Verzeichnispfads für alle

InnoDB-Datendateien. Wenn Sie diesen Wert nicht einstellen, ist das MySQL Data Directory das Ziel. Geben Sie hier einen leeren String an, so können Sie ininnodb_data_file_pathabsolute Dateipfade verwenden.innodb_doublewriteNach Voreinstellung speichert

InnoDBalle Daten zweimal, nämlich zuerst in den Doublewrite-Puffer und dann in die eigentlichen Datendateien. Diese Variable ist standardmäßig eingeschaltet, kann aber mit der Option--skip-innodb_doublewriteausgeschaltet werden, wenn Sie Benchmarks ausführen oder Ihnen eine Top-Performance so wichtig ist, dass Sie sich für Datenintegrität und mögliche Systemabstürze weniger interessieren.innodb_fast_shutdownWenn Sie diese Variable auf 0 setzen, führt

InnoDBvor dem Herunterfahren eine vollständige Purge-Operation und Verschmelzung der Insert-Puffer durch. Diese Operationen können Minuten oder im Extremfall sogar Stunden in Anspruch nehmen. Setzen Sie diese Variable auf 1, übergehtInnoDBbeim Herunterfahren diese Operationen. Der Standardwert ist 1. Wenn Sie ihn auf 2 setzen, leertInnoDBnur die Logs und fährt dann kalt herunter, wie bei einem Absturz von MySQL. Es geht zwar keine committete Transaktion verloren, aber nach dem nächsten Hochfahren wird eine Wiederherstellung gefahren. Den Wert 2 können Sie nicht auf NetWare verwenden.innodb_file_io_threadsDie Anzahl der Dateizugriffs-Threads in

InnoDB. Normalerweise kann man den Standardwert 4 beibehalten, aber auf Windows kann eine größere Zahl die Festplattenzugriffe günstig beeinflussen. Auf Unix bleibt eine Erhöhung dieses Werts ohne Wirkung, daInnoDBimmer den Standardwert verwendet.innodb_file_per_tableWenn diese Variable eingeschaltet ist, erzeugt

InnoDBjede neue Tabelle mit ihrer eigenen.ibd-Datei zum Speichern von Daten und Indizes, anstatt im Shared Tablespace. Nach Voreinstellung werden die Tabellen im Shared Tablespace angelegt. Siehe Abschnitt 14.2.3.1, „Verwendung von Tabellen-Tablespaces (ein Tablespace pro Tabelle)“.innodb_flush_log_at_trx_commitHat

innodb_flush_log_at_trx_commitden Wert 0, wird einmal pro Sekunde der Logpuffer in die Logdatei geschrieben und diese auf die Festplatte zurückgespeichert, doch beim Committen einer Transaktion wird nichts veranlasst. Ist der Wert 1 (der Standard), wird bei jedem Commit der Logpuffer in die Logdatei und diese auf die Festplatte geschrieben. Ist der Wert 2, wird der Puffer bei jedem Commit in die Datei übertragen, aber diese nicht beim Commit, sondern einmal pro Sekunde auf die Festplatte zurückgeschrieben. Beachten Sie jedoch, dass dieser Schreibvorgang aus Gründen der Prozessplanung in Wirklichkeit nicht unbedingt exakt einmal pro Sekunde stattfindet.Der Standardwert dieser Variablen, nämlich 1, ist für die ACID-Fähigkeit erforderlich. Ein anderer Wert als 1 kann zwar die Performance steigern, aber um den Preis, dass Sie bei einem Systemabsturz eine Sekunde an Transaktionen verlieren. Ist der Wert 0, kann jeder Absturz des mysqld-Prozesses die Transaktionen der letzten Sekunde ausradieren. Ist der Wert 2, würde dieser Datenverlust bei einem Betriebssystemabsturz oder Stromausfall eintreten. Da allerdings die Wiederherstellungsfunktion von

InnoDBnicht beeinträchtigt wird, würde die Crash-Recovery unabhängig vom Wert dieser Variablen funktionieren. Beachten Sie jedoch, dass viele Betriebssysteme und einige Festplatten die Flush-to-Disk-Operation irreführen, indem sie mysqld weismachen, dass die Daten bereits auf die Festplatte geschrieben wurden, auch wenn das nicht der Fall ist. Die Dauerhaftigkeit von Transaktionen ist also selbst mit der Einstellung 1 nicht gewährleistet, und im schlimmsten Falle kann ein Stromausfall sogar dieInnoDB-Datenbank beschädigen. Ein batteriegestützter Festplatten-Cache im SCSI-Festplattencontroller oder in der Festplatte selbst kann das Zurückschreiben von Dateien auf die Festplatte beschleunigen und die Operation sicherer machen. Außerdem können Sie mit dem Unix-Befehl hdparm das Caching von Festplatten-Schreibvorgängen in Hardware-Caches deaktivieren oder einen anderen Hardware-spezifischen Befehl verwenden.innodb_flush_methodDie Standardeinstellung

fdatasyncsorgt dafür, dassInnoDBDaten- und Logdateien mitfsync()auf die Festplatte schreibt. Die EinstellungO_DSYNClässtInnoDBLogdateien mitO_SYNCöffnen und auf die Festplatte schreiben, aber für Datendateienfsync()verwenden. Die (auf einigen GNU/Linux-Versionen mögliche) EinstellungO_DIRECTveranlasstInnoDB, Datendateien mitO_DIRECTzu öffnen und Daten- und Logdateien mitfsync()auf die Festplatte schreiben. Beachten Sie, dassInnoDBdie Funktionfsync()anstelle vonfdatasync()benutzt undO_DSYNCnicht standardmäßig einsetzt, weil dies mit vielen Unix-Varianten bereits zu Problemen geführt hat. Diese Variable ist nur für Unix relevant. Auf Windows wird immer und unabänderlichasync_unbufferedzum Zurückschreiben von Daten auf die Festplatte verwendet.innodb_force_recoveryDer Crash-Recovery-Modus. Warnung: Diese Variable sollte nur im Notall, wenn Tabellen aus einer beschädigten Datenbank gesichert werden sollen, auf 0 gesetzt werden! Die Bedeutung der möglichen Werte 1 bis 6 wird in Abschnitt 14.2.8.1, „Erzwingen einer

InnoDB-Wiederherstellung (Recovery)“ erläutert. Als Sicherheitsmaßnahme verhindertInnoDBalle Änderungen an Daten, wenn diese Variable größer als 0 ist.innodb_lock_wait_timeoutGibt an, wie viele Sekunden eine

InnoDB-Transaktion auf eine Sperre wartet, ehe sie zurückgerollt wird.InnoDBentdeckt automatisch Transaktions-Deadlocks in seiner eigenen Sperrentabelle und macht dann die Transaktion rückgängig.InnoDBerkennt Sperren, die mit derLOCK TABLES-Anweisung gesetzt wurden. Die Standardeinstellung beträgt 50 Sekunden.Hinweis: Die größtmögliche Dauerhaftigkeit und Konsistenz in einer Replikationsumgebung mit

InnoDBund Transaktionen erzielen Sie, wenn Sie in dermy.cnf-Datei Ihres Masterserversinnodb_flush_log_at_trx_commit=1undsync_binlog=1einstellen.innodb_locks_unsafe_for_binlogDiese Variable steuert Next-Key-Locking in

InnoDB-Suchoperationen und Index-Scans. Standardmäßig ist diese Variable 0 (deaktiviert) und das Next-Key-Locking somit eingeschaltet.Normalerweise benutzt

InnoDBeinen Algorithmus namens Next-Key-Locking. Zeilensperren funktionieren inInnoDBfolgendermaßen: Wenn ein Tabellenindex durchsucht oder gescannt wird, errichtetInnoDBShared oder exklusive Sperren auf allen gefundenen Indexeinträgen. Somit sind die Zeilensperren in Wirklichkeit Sperren auf Indexeinträgen. Diese Sperren betreffen auch die „Lücke“, die den Indexeinträgen vorausgeht. Wenn ein Benutzer eine Shared oder exklusive Sperre auf Eintrag R eines Index hat, können andere Benutzer keine neuen Indexeinträge unmittelbar vor R in diesen Index einfügen. Ist diese Variable eingeschaltet, wird Next-Key-Locking vonInnoDBnicht nicht in Suchoperationen oder Index-Scans verwendet, wohl aber zur Sicherung von Fremdschlüssel-Constraints und Prüfung auf Schlüsselduplikate. Das Einschalten dieser Variablen kann Phantomprobleme verursachen: Angenommen, Sie möchten alle Kinder derchild-Tabelle, die einen Identifier-Wert größer 100 haben, lesen und sperren, da Sie vorhaben, in den ausgewählten Zeilen später eine Spalte zu ändern:SELECT * FROM child WHERE id > 100 FOR UPDATE;

Nehmen wir weiterhin an, auf der Spalte

idist ein Index definiert. Die Anfrage scannt diesen Index ab dem ersten Eintrag, in demidgrößer als 100 ist. Wenn die auf den Indexeinträgen errichteten Sperren Einfügungen in den Lücken nicht ausschließen, kann ein anderer Client eine neue Zeile in die Tabelle einfügen. Wenn Sie dasselbeSELECTin derselben Transaktion ausführen, sehen Sie in der Ergebnismenge eine neue Zeile. Das führt auch dazu, dassInnoDBbei Einfügung neuer Elemente in die Datenbank keine Serialisierbarkeit garantieren kann. Folglich gewährleistetInnoDBbei Einschaltung dieser Variablen maximal die IsolationsebeneREAD COMMITTED. (Die Konfliktserialisierbarkeit ist aber nach wie vor garantiert.)Die Einschaltung dieser Variablen hat noch einen Zusatzeffekt:

InnoDBsperrt in einemUPDATEoderDELETEnur die Zeilen, die aktualisiert bzw. gelöscht werden. Dadurch werden Deadlocks zwar sehr unwahrscheinlich, können aber immer noch auftreten. Beachten Sie, dass das Einschalten dieser Variablen nach wie vor nicht erlaubt, dassUPDATEandere, ähnliche Operationen (wie etwa ein anderesUPDATE) übernimmt, selbst dann nicht, wenn die beiden Operationen unterschiedliche Zeilen betreffen. Betrachten Sie das nächste Beispiel, das mit folgender Tabelle beginnt:CREATE TABLE A(A INT NOT NULL, B INT) ENGINE = InnoDB; INSERT INTO A VALUES (1,2),(2,3),(3,2),(4,3),(5,2); COMMIT;

Angenommen, ein Client führt folgende Anweisungen aus:

SET AUTOCOMMIT = 0; UPDATE A SET B = 5 WHERE B = 3;

Nehmen wir weiterhin an, dass danach ein anderer Client diese Anweisungen ausführt:

SET AUTOCOMMIT = 0; UPDATE A SET B = 4 WHERE B = 2;

In diesem Fall muss das zweite

UPDATEauf ein Commit oder Rollback des ersten warten. Das ersteUPDATEbesitzt eine exklusive Sperre auf Zeile (2,3) und das zweiteUPDATEversucht, während es die Zeilen scannt, für dieselbe Zeile ebenfalls eine Sperre zu erwerben, die es jedoch nicht bekommt. Das liegt daran, dass das zweiteUPDATEzuerst eine exklusive Sperre auf einer Zeile erwirbt und dann feststellt ob diese Zeile zur Ergebnismenge gehört. Wenn nicht, gibt es die überflüssige Sperre wieder frei, sofern die Variableinnodb_locks_unsafe_for_binlogeingeschaltet ist.Also führt

InnoDBdasUPDATENummer eins folgendermaßen aus:x-lock(1,2) unlock(1,2) x-lock(2,3) update(2,3) to (2,5) x-lock(3,2) unlock(3,2) x-lock(4,3) update(4,3) to (4,5) x-lock(5,2) unlock(5,2)

Das zweite

UPDATEführtInnoDBso aus:x-lock(1,2) update(1,2) to (1,4) x-lock(2,3) - wait for query one to commit or rollback

innodb_log_arch_dirDas Verzeichnis, in dem vollgeschriebene Logdateien archiviert werden, sofern die Archivierung von Logs eingeschaltet ist. Wenn ja, so sollte diese Variable auf denselben Wert wie

innodb_log_group_home_dirgesetzt werden. Das ist jedoch nicht obligatorisch.innodb_log_archiveGibt an, ob

InnoDB-Archivdateien protokolliert werden sollen. Diese Variable ist nur aus historischen Gründen noch vorhanden, wird aber nicht benutzt. Da MySQL die Backup-Recovery anhand seiner eigenen Logdateien durchführt, gibt es keinen Anlass,InnoDB-Logdateien zu archivieren. Die Variable hat den Standardwert 0.innodb_log_buffer_sizeGibt in Bytes die Größe des Puffers an, den

InnoDBbenutzt, um Logdateien auf die Platte zu schreiben. Werte von 1MB bis 8MB sind hier annehmbar. Der Standardwert ist 1MB. Wenn Sie einen großen Logpuffer haben, können umfangreiche Transaktionen zuende laufen, ohne dass das Log vor dem Committen auf die Festplatte zurückgeschrieben werden muss. In einer Umgebung mit großen Transaktionen können Sie also Festplattenzugriffe reduzieren, indem Sie den Logpuffer vergrößern.innodb_log_file_sizeDie Größe jeder Logdatei einer Loggruppe in Bytes. Die kombinierte Größe der Logdateien muss auf 32-Bit-Rechnren weniger als 4GB sein. Der Standard ist 5MB. Annehmbar sind Werte zwischen 1MB und 1/

N-tel der Größe des Bufferpools, wobeiNdie Anzahl der Dateien in einer Loggruppe ist. Je größer der Wert, umso weniger Checkpoint-Flushing ist im Bufferpool erforderlich, was wiederum Plattenzugriffe spart. Allerdings haben große Logdateien auch zur Folge, dass die Recovery nach einem Absturz langsamer läuft.innodb_log_files_in_groupDie Anzahl der Logdateien in der Loggruppe.

InnoDBbenutzt die Dateien in zirkulärer Weise. Der (empfehlenswerte) Standardwert ist 2.innodb_log_group_home_dirDer Verzeichnispfad zu den

InnoDB-Logdateien. Er muss denselben Wert haben wieinnodb_log_arch_dir. Wenn Sie keineInnoDB-Logvariablen angeben, werden nach Voreinstellung zwei 5MB große Dateien namensib_logfile0undib_logfile1im MySQL Data Directory angelegt.innodb_max_dirty_pages_pctEin Integer von 0 bis 100. Der Standardwert ist 90. Der Haupt-Thread in

InnoDBversucht, Seiten aus dem Bufferpool derart zu schreiben, dass der Prozentsatz von noch nicht geschriebenen Seiten diesen Wert nicht übersteigt.innodb_max_purge_lagDiese Variable gibt an, wie lange

INSERT-,UPDATE- undDELETE-Operationen aufgeschoben werden, wenn die Purge-Operationen hinterher hinken (siehe Abschnitt 14.2.12, „Implementierung der Multiversionierung“). Der Standardwert ist 0 (keine Verzögerungen).Das Transaktionssystem von

InnoDBpflegt eine Liste von Transaktionen, die Indexeinträge anhand vonUPDATE- oderDELETE-Operationen zum Löschen vorgemerkt haben. Die Länge dieser Liste seipurge_lag. Wennpurge_lagden Wertinnodb_max_purge_lagüberschreitet, wird jedeINSERT-,UPDATE- undDELETE-Operation um ((purge_lag/innodb_max_purge_lag)×10)–5 Millisekunden aufgeschoben. Diese Verzögerung wird alle zehn Sekunden am Anfang eines Purge-Batch berechnet. Die Operationen werden nicht aufgeschoben, wenn Purge nicht laufen kann, weil eine alte Consistent Read View die zu bereinigenden Zeilen sehen könnte.Eine typische Einstellung für eine problematische Arbeitslast wäre 1 Million, wenn die Transaktionen nur etwa 100 Bytes klein sind und wir 100MB unbereinigte Zeilen in unseren Tabellen gestatten können.

innodb_mirrored_log_groupsGibt an, wie viele identische Kopien von Loggruppen wir für die Datenbank bewahren. Zurzeit sollte dies auf 1 gesetzt werden.

innodb_open_filesDiese Variable ist nur dann von Belang, wenn Sie Multi-Tablespaces in

InnoDBbenutzen. Sie gibt an, wie viele.ibd-DateienInnoDBhöchstens gleichzeitig offen halten kann. Der Mindestwert ist 10 und der Standardwert 300.Die für

.ibd-Dateien verwendeten Dateideskriptoren sind ausschließlich fürInnoDBda. Sie haben nichts mit der Serveroption--open-files-limitzu tun und beeinflussen nicht die Arbeit des Tabellen-Caches.innodb_support_xaDie Einstellung

ONoder 1 (der Standard) schaltet dieInnoDB-Unterstützung für zweiphasigen Commit in XA-Transaktionen ein. Die Aktivierung voninnodb_support_xaverursacht eine zusätzliche Schreiboperation auf der Platte zur Vorbereitung der Transaktion. Wenn Sie sich für XA nicht interessieren, können Sie diese Variable mit der EinstellungOFFoder 0 deaktivieren, was die Schreibvorgänge auf der Festplatte reduziert und dieInnoDB-Performance erhöht.innodb_sync_spin_loopsGibt an, wie oft ein Thread auf die Freigabe eines

InnoDB-Mutex wartet, ehe er suspendiert wird.innodb_table_locksInnoDBbeachtetLOCK TABLES; MySQL kehrt vonLOCK TABLE .. WRITEerst zurück, wenn alle anderen Threads alle ihre Sperren auf der Tabelle freigegeben haben. Der Standardwert 1 bedeutet, dassLOCK TABLESInnoDBveranlasst, eine Tabelle intern zu sperren. In Anwendungen mitAUTOCOMMIT=1können die internen Tabellensperren vonInnoDBDeadlocks verursachen. Sie könneninnodb_table_locks=0in der Datei der Serveroptionen einstellen, um dieses Problem zu beheben.innodb_thread_concurrencyInnoDBversucht, die Anzahl der nebenläufigen Betriebssystem-Threads innerhalb vonInnoDBkleiner oder gleich dem in dieser Variablen festgelegten Höchstwert zu halten. Wenn Sie Performance-Probleme haben undSHOW ENGINE INNODB STATUSzeigt, dass viele Threads auf Semaphoren warten, haben Sie es vielleicht mit Thread-„Überlastung“ zu tun. In diesem Fall setzen sie diese Variable herunter oder herauf. Wenn Ihr Computer über viele Prozessoren und Festplatten verfügt, können Sie diesen Wert heraufsetzen, um Ihre Ressourcen besser auszunutzen. Ein empfehlenswerter Wert ist die Summe der Prozessoren und Festplatten, über die Ihr System verfügt. Beträgt der Wert 500 oder mehr, wird die Nebenläufigkeitsprüfung deaktiviert. Der Standardwert ist 20 und die Nebenläufigkeitsprüfung wird deaktiviert, wenn er auf größer oder gleich 20 eingestellt wird.innodb_thread_sleep_delayGibt in Mikrosekunden an, wie lange

InnoDB-Threads schlafen, bevor sie in dieInnoDB-Schlange eintreten. Der Standardwert ist 10.000. Der Wert 0 schaltet den Schlaf aus.sync_binlogHat diese Variable einen positiven Wert, synchronisiert der MySQL-Server sein Binärlog nach jedem

sync_binlogten Schreibvorgang mittelsfdatasync()auf die Festplatte. Im Autocommit-Modus entsteht pro Anweisung und ansonsten pro Transaktion ein Eintrag ins Binärlog. Der Standardwert 0 veranlasst keine Festplatten-Synchronisierung. Der Wert 1 ist am sichersten, da bei einem Absturz nur maximal eine Anweisung/Transaktion aus dem Binärlog verloren geht. Er ist aber auch am langsamsten (sofern nicht die Festplatte einen batteriegestützten Cache hat; dies würde die Synchronisierung sehr schnell machen).

Angenommen, Sie haben MySQL installiert und die notwendigen

Konfigurationsparameter für InnoDB in die

Konfigurationsdatei geschrieben. Bevor Sie MySQL nun starten,

müssen Sie überprüfen, ob die Verzeichnisse vorhanden sind, die

Sie für InnoDB-Daten- und Logdateien angegeben

haben, und ob der MySQL-Server Zugriffsrechte für diese

Verzeichnisse hat. InnoDB legt keine

Verzeichnisse, sondern nur Dateien an. Prüfen Sie außerdem, ob

Sie genug Platz auf der Festplatte haben, um die Daten- und

Logdateien zu speichern.

Wenn Sie Ihren MySQL-Server mit eingeschaltetem

InnoDB starten, führen Sie

mysqld am besten auf der Kommandozeile und