Inhaltsverzeichnis

- 16.1. MySQL Cluster: Überblick

- 16.2. MySQL Cluster: grundlegende Konzepte

- 16.3. Einfache Schritt-für-Schritt-Anleitung für mehrere Computer

- 16.4. MySQL Cluster: Konfiguration

- 16.5. Prozessverwaltung in MySQL Cluster

- 16.6. Management von MySQL Cluster

- 16.7. Verwendung von Hochgeschwindigkeits-Interconnects mit MySQL Cluster

- 16.8. Bekannte Beschränkungen von MySQL Cluster

- 16.9. MySQL Cluster: Roadmap für die Entwicklung

- 16.10. MySQL Cluster: FAQ

- 16.11. MySQL Cluster: Glossar

MySQL Cluster ist eine hochverfügbare und hochredundante Version

von MySQL, die für verteilte Umgebungen geschaffen wurde. Die

Speicher-Engine NDB Cluster ermöglicht den

Betrieb mehrerer MySQL Server in einem Cluster. Diese

Speicher-Engine ist in den Binär-Releases von MySQL

5.1 und in den RPMs verfügbar, die mit den meisten

modernen Linux-Distributionen kompatibel sind. (Wenn Sie RPM-Dateien

installieren, müssen Sie darauf achten, sowohl die

mysql-server- als auch die

mysql-max-RPMs zu installieren, um MySQL Cluster

zu ermöglichen.)

Gegenwärtig ist MySQL Cluster für Linux, Mac OS X und Solaris verfügbar. (Manche Anwender haben MySQL Cluster auch auf FreeBSD mit Erfolg installieren können, doch dieses System wird von der MySQL AB noch nicht offiziell unterstützt.) Wir arbeiten daran, Cluster auf allen von MySQL unterstützten Betriebssystemen einschließlich Windows lauffähig zu machen, und werden diese Seite aktualisieren, wenn ein neues Betriebssystem hinzukommt.

Dieses Kapitel ändert sich noch laufend; sein Inhalt wird immer wieder an den aktuellen Stand von MySQL Cluster angepasst. Weitere Informationen über MySQL Cluster finden Sie auf der Website von MySQL AB unter http://www.mysql.com/products/cluster/.

Antworten auf häufig gestellte Fragen zum Thema Cluster finden Sie unter Abschnitt 16.10, „MySQL Cluster: FAQ“.

Die Mailingliste zu MySQL Cluster: http://lists.mysql.com/cluster.

Das MySQL Cluster-Forum: http://forums.mysql.com/list.php?25.

Wenn Sie MySQL Cluster noch nicht kennen, ist eventuell der folgende Artikel aus unserer Developer Zone für Sie interessant: How to set up a MySQL Cluster for two servers.

MySQL Cluster ist eine Technologie für das Clustering von speicherresidenten Datenbanken in einem Share-Nothing-System. Mit der Share-Nothing-Architektur kann das System auf sehr preiswerter Hardware laufen und es gibt keine besonderen Anforderungen an Hardware oder Software. Überdies ist kein Single Point of Failure vorhanden, da jede Komponente ihren eigenen Arbeitsspeicher und ihre Festplatte hat.

MySQL Cluster integriert den normalen MySQL Server in eine

speicherresidente geclusterte Speicher-Engine namens

NDB. In unserer Dokumentation bezeichnet der

Begriff NDB den Teil des Setups, der für die

jeweilige Speicher-Engine spezifisch ist, während mit

„MySQL Cluster“ die Kombination aus MySQL und der

Speicher-Engine NDB gemeint ist.

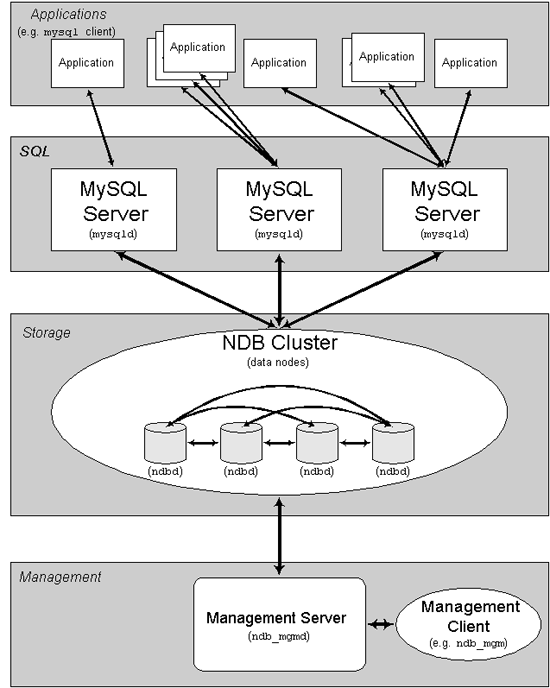

Ein MySQL Cluster besteht aus mehreren Computern, auf denen jeweils eine Anzahl Prozesse laufen, darunter MySQL Server, Datenknoten für NDB Cluster, Management-Server und (möglicherweise) besondere Programme für den Datenzugriff. Im Folgenden wird gezeigt, wie diese Komponenten in einem Cluster zueinander in Beziehung stehen:

Alle diese Programme arbeiten zusammen, um ein MySQL Cluster zu

bilden. Wenn in der Speicher-Engine NDB Cluster

Daten gespeichert werden, werden die Tabellen in den Datenknoten

untergebracht. Auf solche Tabellen können alle anderen MySQL

Server im Cluster direkt zugreifen. Wenn also beispielsweise ein

Gehaltsabrechnungsprogramm Daten in einem Cluster speichert und

eine Anwendung das Gehalt eines Mitarbeiters ändert, können alle

anderen MySQL Server, die diese Daten abfragen, sofort die

Änderung erkennen.

Die in den Datenknoten für MySQL Cluster abgelegten Daten können gespiegelt werden. Der Cluster kann also mit Fehlern in einzelnen Datenknoten gut umgehen; die einzige Auswirkung wäre die, dass einige wenige Transaktionen abbrechen, weil sie ihren Transaktionsstatus verlieren. Da Anwendungen, die Transaktionen vornehmen, auch mit dem Scheitern einer Transaktion umgehen können, dürfte dies kein Problem sein.

Mit der Einführung von MySQL Cluster in die Open-Source-Szene stellt die MySQL AB jedem, der es benötigt, eine hochverfügbare, leistungsfähige und skalierbare geclusterte Datenverwaltung zur Verfügung.

NDB ist eine hochverfügbare speicherresidente Speicher-Engine mit Fähigkeiten für die Datenpersistenz.

Die Speicher-Engine NDB kann mit mehreren Optionen für Ausfallsicherung und Lastverteilung konfiguriert werden, doch am einfachsten ist es, das System mit der Speicher-Engine auf der Cluster-Ebene zu starten. Die Speicher-Engine NDB von MySQL Cluster enthält vollständige Daten, deren Abhängigkeiten sich lediglich auf andere Daten in demselben Cluster beziehen.

Im Folgenden erfahren Sie, wie man einen MySQL Cluster einrichtet, der aus der Speicher-Engine NDB und einigen MySQL Servern besteht.

Der Cluster-Teil von MySQL Cluster ist gegenwärtig unabhängig von den MySQL Servern konfiguriert. In MySQL Cluster wird jeder Teil des Clusters als ein Knoten betrachtet.

Hinweis: In vielen Zusammenhängen wird der Begriff „Knoten“ für einen Computer verwendet, doch im Zusammenhang mit MySQL Cluster ist damit ein Prozess gemeint. Auf einem einzigen Computer, dem so genannten Cluster-Host, können also beliebig viele Knoten existieren.

Es gibt drei Arten von Cluster-Knoten und eine Minimalkonfiguration von MySQL besteht aus drei Knoten, je einem von jeder Art:

dem Management-Knoten (MGM-Knoten): Dieser verwaltet andere Knoten im MySQL Cluster, indem er zum Beispiel Konfigurationsdaten zur Verfügung stellt, Knoten startet und anhält, eine Sicherung ausführt usw. Da dieser Knotentyp die Konfiguration der anderen Knoten managt, sollten Knoten dieses Typs immer als Erste, vor allen anderen Knoten, gestartet werden. Ein MGM-Knoten wird mit dem Befehl ndb_mgmd gestartet.

dem Datenknoten: Dies ist der Knotentyp, der die Daten des Clusters speichert. Die Anzahl der Datenknoten beträgt Replikas mal Anzahl Fragmente. Wenn Sie beispielsweise zwei Replikas mit je zwei Fragmenten haben, benötigen Sie vier Datenknoten. Noch mehr Replikas sind nicht notwendig. Ein Datenknoten wird mit dem Befehl ndbd gestartet.

dem SQL-Knoten: Mit diesem Knotentyp wird auf die Cluster-Daten zugegriffen. In MySQL Cluster ist ein Client-Knoten ein traditioneller MySQL Server, der die Speicher-Engine

NDB Clusternutzt. Ein SQL-Knoten wird normalerweise mit dem Befehl mysqld --ndbcluster gestartet, oder auch mit mysqld und der Optionndbclusterin dermy.cnf-Datei.

Eine kurze Einführung in die Beziehungen zwischen Knoten, Knotengruppen, Replikas und Partitionen in MySQL Cluster finden Sie in Abschnitt 16.2.1, „MySQL Cluster: Knoten, Knotengruppen, Repliken und Partitionen“.

Um einen Cluster zu konfigurieren, müssen Sie jeden Einzelnen seiner Knoten konfigurieren und individuelle Kommunikationsverbindungen zwischen den Knoten einrichten. Der Entwurf von MySQL Cluster zielt gegenwärtig darauf ab, dass die Speicherknoten alle denselben Bedarf an Prozessorleistung, Speicherplatz und Bandbreite haben. Um überdies nur an einer einzigen Stelle konfigurieren zu müssen, liegen sämtliche Konfigurationen für den gesamten Cluster in nur einer Konfigurationsdatei.

Der Management-Server (MGM-Knoten) verwaltet die Konfigurationsdatei und das Log für den Cluster. Da sich jeder Knoten im Cluster seine Konfigurationsdaten vom Management-Server holt, muss der Knoten feststellen können, wo der Management-Server zu finden ist. Wenn interessante Ereignisse in den Datenknoten eintreten, übermitteln die Knoten Informationen über diese Ereignisse an den Management-Server, der diese Daten dann an das Cluster-Log überträgt.

Darüber hinaus können beliebig viele Cluster-Clientprozesse oder -anwendungen ablaufen. Von diesen gibt es zwei Arten:

Standard-MySQL-Clients: Diese unterscheiden sich von MySQL Cluster nur insofern, als sie eben nicht geclustert sind. Also können Sie auch von vorhandenen MySQL-Anwendungen, die in PHP, Perl, C, C++, Java, Python, Ruby usw. geschrieben wurden, auf MySQL Cluster zugreifen.

Management-Clients: Diese Clients verbinden sich mit dem Management-Server und kennen Befehle, um Knoten elegant zu starten oder abzubrechen, das Message-Tracing ein- und auszuschalten (nur in den Debugversionen), Knotenversionen und -status anzuzeigen, Sicherungen zu starten oder anzuhalten usw.

In diesem Abschnitt wird beschrieben, wie MySQL Cluster mehrfach vorhandene Daten für die Speicherung aufteilt.

Die Konzepte, die im Folgenden mit kurzen Definitionen aufgelistet werden, sind für das Verständnis dieses Themas unerlässlich:

(Daten-)Knoten: Ein ndbd-Prozess, der eine Replik speichert, also eine Kopie der Partition (siehe unten), die der Knotengruppe, zu welcher dieser Knoten gehört, zugewiesen wurde.

Normalerweise liegt jeder Datenknoten auf einem anderen Computer. Es ist jedoch möglich, mehrere Datenknoten auf einem einzigen Computer unterzubringen, wenn dieser über mehrere Prozessoren verfügt. In solchen Fällen kann pro physikalische CPU eine ndbd-Instanz laufen. (Beachten Sie, dass ein Prozessor mit mehreren Zentraleinheiten immer noch ein einzelner Prozessor ist.)

Die Begriffe „Knoten“ und „Datenknoten“ werden im Zusammenhang mit ndbd-Prozessen synonym verwendet. Wenn Management-Knoten (ndb_mgmd -Prozesse) und SQL-Knoten (mysqld-Prozesse) gemeint sind, wird dies im Text ausdrücklich gesagt.

Knotengruppe: Eine Knotengruppe besteht aus einem oder mehreren Knoten und speichert eine Partition oder eine Menge von Replikas (siehe nächster Eintrag).

Hinweis: Gegenwärtig müssen alle Gruppen in einem Cluster gleich viele Knoten haben.

Partition: Ein Teil der in einem Cluster gespeicherten Daten. Es gibt so viele Cluster-Partitionen, wie Knotengruppen im Cluster vorliegen, und jede Knotengruppe ist dafür verantwortlich, mindestens eine Kopie der ihr zugewiesenen Partition (also mindestens eine Replik) aufzubewahren, die dem Cluster zur Verfügung steht.

Replik: Eine Kopie einer Cluster-Partition. Jeder Knoten in einer Knotengruppe speichert eine Replik. Wird gelegentlich auch als Partitionsreplik bezeichnet.

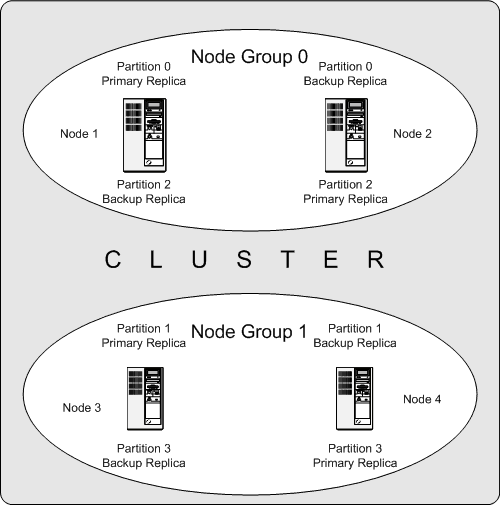

Das folgende Diagramm zeigt einen MySQL Cluster mit vier Datenknoten in zwei Knotengruppen zu je zwei Knoten. Beachten Sie, dass hier nur die Datenknoten gezeigt werden, obwohl ein funktionierender Cluster einen ndb_mgm-Prozess für das Cluster-Management und mindestens einen SQL-Knoten für den Zugriff auf die im Cluster gespeicherten Daten benötigt.

Die in diesem Cluster gespeicherten Daten sind auf vier Partitionen verteilt, die mit 0, 1, 2 und 3 nummeriert sind. Jede Partition wird – in mehrfachen Kopien – in derselben Knotengruppe gespeichert. Partitionen werden auf unterschiedlichen Knotengruppen gespeichert:

Partition 0 wird in Knotengruppe 0 gespeichert; eine primäre Replik (oder primäre Kopie) wird auf Knoten 1 gespeichert, und eine Backup-Replik (Backup-Kopie der Partition) auf Knoten 2.

Partition 1 wird auf der anderen Knotengruppe gespeichert (Knotengruppe 1); die primäre Replik dieser Partition ist auf Knoten 3 und die Backup-Repli befindet sich auf Knoten 4.

Partition 2 wird auf Knotengruppe 0 gespeichert. Die Platzierung ihrer beiden Repliken ist jedoch genau umgekehrt wie bei Partition 0: Bei Partition 2 wird die primäre Replik auf Knoten 2 und die Backup-Replik auf Knoten 1 gespeichert.

Partition 3 wird auf Knotengruppe 1 gespeichert, und die Platzierung ihrer beiden Repliken ist umgekehrt wie bei Partition 1. Mit anderen Worten befindet sich ihre primäre Replik auf Knoten 4 und die Backup-Replik auf Knoten 3.

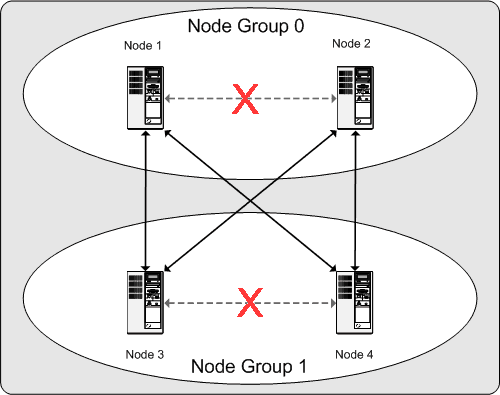

Für den Dauerbetrieb eines MySQL Clusters bedeutet dies: Solange jede Knotengruppe des Clusters mindestens einen funktionierenden Knoten hat, ist der Cluster im Besitz einer vollständigen Kopie sämtlicher Daten und bleibt funktionstüchtig. Dies wird im nächsten Diagramm veranschaulicht.

In diesem Beispiel, in dem der Cluster aus zwei Knotengruppen mit je zwei Knoten besteht, genügt eine beliebige Kombination mindestens eines Knotens aus Gruppe A und mindestens eines weiteren Knotens aus Gruppe B, um den Cluster „am Leben“ zu halten (wie es die Pfeile im Diagramm zeigen). Wenn jedoch beide Knoten einer Knotengruppe versagen, genügen die verbleibenden beiden Knoten nicht, um den Betrieb aufrechtzuerhalten (dies zeigen die mit X markierten Pfeile). In beiden Fällen hat der Cluster eine vollständige Partition verloren und kann somit nicht mehr auf alle Cluster-Daten Zugriff geben.

Dieser Abschnitt ist eine „Anleitung“, welche in Grundzügen beschreibt, wie man einen MySQL Cluster plant, installiert, konfiguriert und ausführt. Die Beispiele in Abschnitt 16.4, „MySQL Cluster: Konfiguration“, bieten zwar ausführlichere Informationen über verschiedene Cluster-Optionen und Konfigurationen, aber auch mit dem hier gezeigten Verfahren erhalten Sie einen brauchbaren MySQL Cluster, der ein Minimum an Verfügbarkeit und Datensicherheit bietet.

Dieser Abschnitt behandelt Hardware- und Softwarevoraussetzungen, Netzwerkfragen, die Installation eines MySQL Clusters, die Konfiguration, das Starten, Anhalten und Neustarten eines Clusters, das Laden einer Beispieldatenbank sowie die Ausführung von Anfragen.

Grundvoraussetzungen

Diese Anleitung setzt Folgendes voraus:

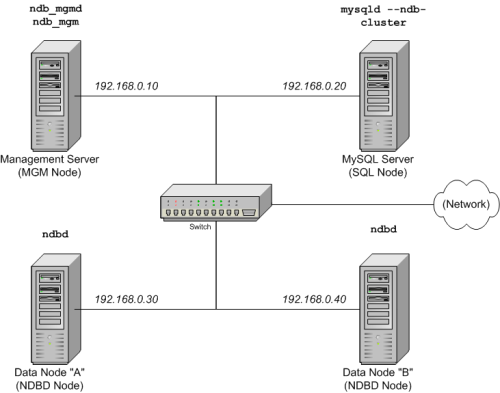

Der Cluster hat vier Knoten, von denen jeder auf einem separaten Host residiert und eine feste Netzwerkadresse in einem typischen Ethernet besitzt, wie es hier gezeigt wird:

Knoten IP-Adresse Management(MGM)-Knoten 192.168.0.10 MySQL Server(SQL)-Knoten 192.168.0.20 Datenknoten (NDBD-Knoten) "A" 192.168.0.30 Datenknoten (NDBD-Knoten) "B" 192.168.0.40 Dies wird möglicherweise im nachfolgenden Diagramm klarer:

Hinweis: Im Interesse der Einfachheit (und Zuverlässigkeit) verwendet diese Anleitung nur numerische IP-Adressen. Wenn jedoch in Ihrem Netzwerk DNS-Namensauflösung verfügbar ist, können Sie anstelle von IP-Adressen in der Cluster-Konfiguration auch Hostnamen verwenden. Alternativ können Sie in der Datei

/etc/hostsoder der in Ihrem Betriebssystem verwendeten Entsprechung eine andere Möglichkeit für das Host-Lookup einrichten (soweit verfügbar).Jeder Host in unserem Szenario ist ein Intel-PC, auf dem eine normale generische Linux-Distribution in einer Standardkonfiguration auf der Festplatte installiert ist und keine unnötigen Dienste laufen. Das Kernbetriebssystem mit seinen Standard-TCP/IP-Netzwerkfähigkeiten müsste ausreichen. Der Einfachheit halber setzen wir des Weiteren voraus, dass die Dateisysteme auf allen Hosts gleich eingerichtet sind. Anderenfalls müssen Sie diese Anleitungen entsprechend anpassen.

Auf jedem Computer sind Standard-Ethernet-Karten mit 100 Mbps oder 1 Gigabit samt Treibern installiert und alle vier Hosts sind durch eine Standardvorrichtung für Ethernet-Netzwerke, wie beispielsweise einen Switch, miteinander verbunden. (Alle Computer sollten Netzwerkkarten mit demselben Datendurchsatz verwenden, d. h., die vier Computer haben entweder 100-Mbps-Karten oder 1-Gbps-Karten.) MySQL Cluster funktioniert zwar auch in einem 100-Mbps-Netzwerk, aber ein 1-Gigabit-Ethernet bietet deutlich mehr Leistung.

Beachten Sie, dass MySQL Cluster nicht für den Einsatz in einem Netzwerk mit weniger als 100 Mbps Datendurchsatz gedacht ist. Aus diesem und anderen Gründen werden Sie keinen Erfolg haben, wenn Sie versuchen, einen MySQL Cluster in einem öffentlichen Netzwerk wie dem Internet zu betreiben. Das ist auch nicht empfehlenswert.

Für unsere Beispieldaten verwenden wir die Datenbank

world, die Sie von der Website der MySQL AB herunterladen können. Da diese Datenbank relativ wenig Speicherplatz belegt, gehen wir davon aus, dass jeder Computer 256 Mbyte RAM besitzt. Dies dürfte ausreichen, um das Betriebssystem auszuführen, den NDB-Prozess zu hosten und die Datenbank (die Datenknoten) zu speichern.

Auch wenn wir uns in dieser Anleitung auf ein Linux-Betriebssystem beziehen, lassen sich die hier geschilderten Instruktionen und Verfahren auch auf Solaris oder Mac OS X leicht übertragen. Außerdem setzen wir voraus, dass Sie bereits wissen, wie man eine Minimalinstallation durchführt und das Betriebssystem für den Netzwerkbetrieb konfiguriert, oder dass Sie sich in diesen Fragen notfalls an anderer Stelle kundig machen können.

Im nächsten Abschnitt werden Hardware-, Software- und Netzwerkvoraussetzungen für MySQL Cluster etwas eingehender behandelt. (Siehe Abschnitt 16.3.1, „Hardware, Software und Netzwerk“.)

Eine Stärke von MySQL Cluster besteht darin, dass das System auf handelsüblicher Hardware läuft und in dieser Hinsicht keine besonderen Ansprüche stellt – abgesehen von einem großen Arbeitsspeicher, da im Betrieb sämtliche Daten dort gespeichert werden. (Dies wird sich allerdings noch ändern, da in einem künftigen Release von MySQL Cluster eine Datenspeicherung auf Festplatte angestrebt wird.) Natürlich wird die Leistung umso besser, je mehr und je schnellere CPUs eingesetzt werden. Der Speicherbedarf für Cluster-Prozesse ist relativ gering.

Auch an die Software stellt Cluster eher geringe Anforderungen.

Die Host-Betriebssysteme benötigen keine ungewöhnlichen

Module, Dienste, Anwendungen oder Konfigurationen, um MySQL

Cluster zu unterstützen. Für Mac OS X oder Solaris reicht

sogar die Standardinstallation völlig aus. Für Linux dürfte

gleichfalls die Standardinstallation hinreichend sein. Die

Anforderungen an MySQL-Software lassen sich ebenfalls leicht

erfüllen: Sie benötigen lediglich einen Produktions-Release

von MySQL-max 5.1. Um Cluster-Unterstützung zu

bekommen, müssen Sie die

-max-Version von

MySQL einsetzen, brauchen MySQL jedoch nicht selbst zu

kompilieren. In dieser Anleitung setzen wir voraus, dass Sie die

passende -max-Binärversion zu Ihrem

Betriebssystem Linux, Solaris oder Mac OS X verwenden, die unter

den Softwaredownloads von MySQL unter

http://dev.mysql.com/downloads/ erhältlich ist.

Für die Kommunikation zwischen den Knoten unterstützt Cluster TCP/IP-Netzwerke in einer beliebigen Standardtopologie, wofür jeder Host als Minimum eine Standard-Ethernet-Karte mit 100 Mbps plus Switch, Hub oder Router benötigt, um die Netzwerkkonnektivität für den Cluster als Ganzes herzustellen. Wir raten Ihnen dringend, MySQL Cluster in einem eigenen Subnetz zu betreiben, auf das keine Computer zugreifen, die nicht an dem Cluster partizipieren. Dafür gibt es folgende Gründe:

Sicherheit: Die Kommunikation zwischen Cluster-Knoten ist in keiner Weise verschlüsselt oder abgeschirmt. Die einzige Möglichkeit, Datenübertragungen in einem MySQL Cluster zu schützen, besteht darin, den Cluster in einem geschützten Netzwerk auszuführen. Wenn Sie MySQL Cluster für Webanwendungen nutzen möchten, muss der Cluster unbedingt hinter Ihrer Firewall sitzen und nicht etwa in der demilitarisierten Zone Ihres Netzwerks (DMZ) oder an einer anderen Stelle.

Effizienz: Wenn Sie einen MySQL Cluster in einem privaten oder geschützten Netzwerk einrichten, kann er über die Bandbreite zwischen den Cluster-Hosts alleine verfügen. Indem Sie für Ihren MySQL Cluster einen getrennten Switch verwenden, schützen Sie die Cluster-Daten vor unbefugtem Zugriff und gewährleisten überdies, dass die Cluster-Knoten von den Interferenzen durch Datenübertragungen zwischen anderen Computern im Netzwerk verschont bleiben. Die Zuverlässigkeit können Sie durch doppelte Switches und doppelte Karten erhöhen; so scheidet das Netzwerk als Single Point of Failure aus. Viele Gerätetreiber unterstützen eine Ausfallsicherung für solche Kommunikationsverbindungen.

Es ist auch möglich, das sehr schnelle Scalable Coherent Interface (SCI) mit MySQL Cluster zu kombinieren, aber obligatorisch ist es nicht. Unter Abschnitt 16.7, „Verwendung von Hochgeschwindigkeits-Interconnects mit MySQL Cluster“, erfahren Sie mehr über dieses Protokoll und seine Verwendung mit MySQL Cluster.

Auf jedem Hostcomputer für MySQL Cluster, der Speicher- oder SQL-Knoten ausführt, muss MySQL als -max-Binärversion installiert sein. Für Management-Knoten muss zwar nicht die Binärversion von MySQL Server installiert werden, wohl aber die Binärversionen von MGM Server Daemon und vom Client (ndb_mgmd und ndb_mgm). In diesem Abschnitt erfahren Sie alles Notwendige, um für jede Art von Cluster-Knoten die richtige Binärversion zu installieren.

MySQL AB bietet vorkompilierte Binärversionen, die Cluster

unterstützen und die Sie generell nicht selbst kompilieren

müssen. Der erste Schritt zur Installation jedes Cluster-Hosts

besteht also darin, die Datei

mysql-max-5.1.5-alpha-pc-linux-gnu-i686.tar.gz

aus dem

MySQL-Downloadbereich

herunterzuladen. Wir gehen davon aus, dass Sie diese Datei in

das Verzeichnis /var/tmp jedes Computers

legen. (Sollten Sie doch eine maßgeschneiderte Binärversion

benötigen, schauen Sie bitte unter

Abschnitt 2.8.3, „Installation vom Entwicklungs-Source-Tree“, nach.)

RPMs gibt es auch für 32-Bit- und 64-Bit-Linux-Systeme. Die von

den RPMs installierten -max-Binaries

unterstützen die Speicher-Engine NDBCluster.

Wenn Sie diese anstelle der Binärdateien einsetzen möchten,

müssen Sie allerdings beide Packages -

-server und -max - auf

allen Computern installieren, die Cluster-Knoten hosten sollen.

(Unter Abschnitt 2.4, „MySQL unter Linux installieren“, erfahren Sie mehr darüber,

wie man MySQL mithilfe der RPMs installiert.) Nach der

Installation von RPM müssen Sie noch den Cluster konfigurieren,

wie in Abschnitt 16.3.3, „Konfiguration im Mehrcomputerbetrieb“, beschrieben.

Hinweis: Nach Abschluss der Installation dürfen Sie noch nicht die Binaries starten. Wie Sie das tun, zeigen wir Ihnen, nachdem sämtliche Knoten konfiguriert sind.

Speicherung und Installation des SQL-Knotens

Auf allen drei Computern, die Speicher- oder SQL-Knoten hosten

sollen, müssen Sie als root-User folgende

Schritte ausführen:

Sie müssen in den Dateien

/etc/passwdund/etc/groupnachschauen (oder die Tools nutzen, die Ihr Betriebssystem zur Verwaltung von Benutzern und Gruppen zur Verfügung stellt), um festzustellen, ob auf dem System bereits einemysql-Gruppe und einmysql-Benutzer vorhanden ist. Manche Betriebssystem-Distributionen legen diese bei ihrer Installation bereits an. Wenn sie noch nicht vorhanden sind, legen Sie eine neuemysql-Benutzergruppe an und fügen dieser dann einenmysql-Benutzer hinzu:shell>

groupadd mysqlshell>useradd -g mysql mysqlDie Syntax für useradd und groupadd kann auf verschiedenen Unix-Versionen etwas abweichen. Es ist auch möglich, dass die Befehle etwas andere Namen haben, wie etwa adduser und addgroup.

Dann wechseln Sie in das Verzeichnis mit der heruntergeladenen Datei, packen das Archiv aus und erzeugen einen Symlink auf die Executable mysql-max. Beachten Sie, dass die tatsächlichen Datei- und Verzeichnisnamen je nach MySQL-Version unterschiedlich sind.

shell>

cd /var/tmpshell>tar -xzvf -C /usr/local/bin mysql-max-5.1.5-alpha-pc-linux-gnu-i686.tar.gzshell>ln -s /usr/local/bin/mysql-max-5.1.5-alpha-pc-linux-gnu-i686 mysqlNun gehen Sie in das Verzeichnis

mysqlund führen das mitgelieferte Skript aus, das die Systemdatenbanken anlegt:shell>

cd mysqlshell>scripts/mysql_install_db --user=mysqlNun stellen Sie die Berechtigungen für den MySQL Server und die Datenverzeichnisse ein:

shell>

chown -R root .shell>chown -R mysql datashell>chgrp -R mysql .Beachten Sie, dass das Datenverzeichnis auf jedem Computer, auf dem ein Datenknoten residiert, unter

/usr/local/mysql/dataliegt. Dieses Wissen werden wir nutzen, wenn wir den Management-Knoten konfigurieren. (Siehe Abschnitt 16.3.3, „Konfiguration im Mehrcomputerbetrieb“.)Kopieren Sie das MySQL-Startskript in das passende Verzeichnis, sorgen Sie dafür, dass es ausführbar ist, und stellen Sie ein, dass es beim Hochfahren des Betriebssystems läuft:

shell>

cp support-files/mysql.server /etc/rc.d/init.d/shell>chmod +x /etc/rc.d/init.d/mysql.servershell>chkconfig --add mysql.serverHier legen wir die Verknüpfungen zu den Startskripten mit dem Befehl chkconfig von Red Hat an. Bitte wählen Sie das für Ihr Betriebssystem jeweils passende Mittel aus, etwa update-rc.d für Debian.

Die obigen Schritte müssen auf jedem Computer, der einen Speicher- oder SQL-Knoten hostet, separat ausgeführt werden.

Installation des Management-Knotens

Um den Management(MGM)-Knoten installieren zu können, muss die

mysqld-Binary nicht installiert sein. Nur die

Binärversionen für den MGM-Server und -Client sind

erforderlich. Diese finden Sie im heruntergeladenen

-max-Archiv. Wir gehen wieder davon aus, dass

Sie die Datei in das Verzeichnis /var/tmp

gespeichert haben.

Die folgenden Schritte müssen Sie als

root-User Ihres Systems ausführen (das

heißt nach Ausführung von sudo, su

root oder dem für Ihr System passenden Befehl zur

vorübergehenden Einrichtung von Administratorrechten). Dann

installieren Sie auf dem Host des Cluster-Management-Knotens

ndb_mgmd und ndb_mgm wie

folgt:

Gehen Sie in das Verzeichnis

/var/tmpund extrahieren Sie ndb_mgm und ndb_mgmd aus dem Archiv in ein passendes Verzeichnis wie beispielsweise/usr/local/bin:shell>

cd /var/tmpshell>tar -zxvf mysql-max-5.1.5-alpha-pc-linux-gnu-i686.tar.gz \/usr/local/bin '*/bin/ndb_mgm*'Gehen Sie in das Verzeichnis, in das Sie die Dateien entpackt haben, und machen Sie beide ausführbar:

shell>

cd /usr/local/binshell>chmod +x ndb_mgm*

In Abschnitt 16.3.3, „Konfiguration im Mehrcomputerbetrieb“, werden wir Konfigurationsdateien für alle Knoten unseres Beispiel-Clusters erstellen und schreiben.

Für unseren MySQL Cluster mit vier Knoten und vier Hosts müssen wir vier Konfigurationsdateien schreiben, je eine pro Knoten/Host.

Jeder Datenknoten oder SQL-Knoten benötigt eine

my.cnf-Datei, die zwei Informationen liefert: einen connectstring, der dem Knoten sagt, wo er den MGM-Knoten findet, und eine Leitung, die den MySQL Server auf diesem Host (dem Computer mit dem Datenknoten) anweist, im NDB-Modus zu laufen.Mehr zum Thema Verbindungs-Strings erfahren Sie unter Abschnitt 16.4.4.2, „MySQL Cluster:

connectstring“.Der Management-Knoten benötigt eine

config.ini-Datei, die ihm sagt, wie viele Replikas er pflegen soll, wie viel Speicher er für die Daten und Indizes auf jedem Datenknoten reservieren soll, wo er die Datenknoten suchen soll, wo er die Daten für jeden Datenknoten auf Platte speichern soll und wo er SQL-Knoten finden kann.

Konfiguration der Speicher- und SQL-Knoten

Die für die Datenknoten erforderliche

my.cnf-Datei ist ganz einfach. Diese

Konfigurationsdatei sollte im Verzeichnis

/etc liegen und kann mit jedem Editor

bearbeitet werden. (Wenn die Datei noch nicht existiert, legen

Sie sie bitte an.) Zum Beispiel:

shell> vi /etc/my.cnf

Hier legen wir die Datei zwar mit vi an, aber Sie können auch jeden anderen Editor benutzen.

Für jeden Daten- und SQL-Knoten in unserem Beispiel-Cluster

sollte die my.cnf-Datei folgendermaßen

aussehen:

# Optionen für den mysqld-Prozess: [MYSQLD] ndbcluster # NDB-Engine ausführen ndb-connectstring=192.168.0.10 # Speicherort des MGM-Knotens # Optionen für den ndbd-Prozess: [MYSQL_CLUSTER] ndb-connectstring=192.168.0.10 # Speicherort des MGM-Knotens

Wenn Sie diese Daten eingegeben haben, speichern Sie die Datei und schließen den Editor. Dies tun Sie für die Hosts der Datenknoten „A“ und „B“ sowie für den Host des SQL-Knotens.

Konfiguration des Management-Knotens

Der erste Schritt zur Konfiguration des MGM-Knotens besteht

darin, das Verzeichnis für die Konfigurationsdatei und dann die

Datei selbst anzulegen. Zum Beispiel (immer als

root-User):

shell>mkdir /var/lib/mysql-clustershell>cd /var/lib/mysql-clustershell>vi config.ini

Für unseren Beispiel-Cluster sieht die

config.ini-Datei folgendermaßen aus:

# Optionen, die ndbd-Prozesse auf allen Datenknoten betreffen:

[NDBD DEFAULT]

NoOfReplicas=2 # Anzahl der Replikas

DataMemory=80M # So viel Speicher wird für Datenknoten reserviert

IndexMemory=18M # So viel Speicher wird für Indizes reserviert

# Für DataMemory und IndexMemory haben wir die Standardwerte

# eingesetzt. Da die "world"-Datenbank nur

# circa 500 Kbyte belegt, dürfte dies für unseren Beispiel-Cluster

# mehr als ausreichend sein.

# TCP/IP options:

[TCP DEFAULT]

portnumber=2202 # Dies ist der Standardwert. Sie können jedoch

# jeden Port benutzen, der auf allen Hosts im Cluster frei ist.

# Hinweis: Ab MySQL 5.0 ist es ratsam, keine

# Portnummer anzugeben, sondern einfach

# die Verwendung des Standardwerts zu gestatten

# Optionen für den Management-Prozess:

[NDB_MGMD]

hostname=192.168.0.10 # Hostname oder IP-Adresse des MGM-Knotens

datadir=/var/lib/mysql-cluster # Verzeichnis der Logdateien für MGM-Knoten

# Optionen für Datenknoten "A":

[NDBD]

# (ein [NDBD]-Abschnitt pro Datenknoten)

hostname=192.168.0.30 # Hostname oder IP-Adresse

datadir=/usr/local/mysql/data # Verzeichnis für die Datendateien dieses Knotens

# Optionen für Datenknoten "B":

[NDBD]

hostname=192.168.0.40 # Hostname oder IP-Adresse

datadir=/usr/local/mysql/data # Verzeichnis für die Datendateien dieses Knotens

# Optionen für SQL-knoten:

[MYSQLD]

hostname=192.168.0.20 # Hostname oder IP-Adresse

# (Weitere mysqld-Verbindungen können

# für diverse Zwecke, z. B. Ausführung von

# ndb_restore, für diesen Knoten angegeben werden.)

(Hinweis: Die Datenbank

world kann von http://dev.mysql.com/doc/

heruntergeladen werden, wo sie unter „Examples.“

aufgeführt ist.)

Wenn alle Konfigurationsdateien angelegt und diese minimalen Optionen angegeben sind, können Sie den Cluster starten und sich vergewissern, dass alle Prozesse laufen. Wie das geht, erfahren Sie in Abschnitt 16.3.4, „Erster Start“.

Detailliertere Informationen über die verfügbaren Konfigurationsparameter von MySQL Cluster und ihre Verwendung finden Sie unter Abschnitt 16.4.4, „Konfigurationsdatei“, und Abschnitt 16.4, „MySQL Cluster: Konfiguration“. Wie Sie MySQL Cluster für die Erstellung von Datensicherungen konfigurieren, erfahren Sie unter Abschnitt 16.6.5.4, „Konfiguration für Cluster-Backup“.

Hinweis: Der Standardport für Cluster-Management-Knoten ist 1186 und der Standardport für Datenknoten ist 2202. Seit MySQL 5.0.3 wurde diese Einschränkung aufgehoben und der Cluster weist automatisch Ports für Datenknoten aus dem Vorrat der freien Ports zu.

Den Cluster nach erfolgter Konfiguration zu starten ist nicht schwer. Jeder Cluster-Knoten-Prozess muss separat und auf dem Knoten-Host gestartet werden. Zwar können die Knoten in beliebiger Reihenfolge gestartet werden, aber es empfiehlt sich, als Erstes den Management-Knoten, dann die Speicherknoten und zum Schluss die SQL-Knoten zu starten:

Auf dem Management-Host setzen Sie folgenden Befehl in der System-Shell ab, um den MGM-Knoten-Prozess zu starten:

shell>

ndb_mgmd -f /var/lib/mysql-cluster/config.iniBeachten Sie, dass Sie ndb_mgmd mithilfe der Option

-foder--config-filemitteilen müssen, wo er seine Konfigurationsdatei finden kann. (Einzelheiten siehe Abschnitt 16.5.3, „ndb_mgmd, der Management-Server-Prozess“.)Auf jedem Datenknoten-Host geben Sie folgenden Befehl, um den ndbd-Prozess zum ersten Mal zu starten:

shell>

ndbd --initialEs ist äußerst wichtig, dass der Parameter

--initialnur beim ersten Start von ndbd oder bei einem Neustart nach einer Sicherungs-/Wiederherstellungsoperation oder einer Konfigurationsänderung verwendet wird. Denn die Option--initialveranlasst den Knoten, alle für die Wiederherstellung erforderlichen Dateien zu löschen, die von vorherigen ndbd-Instanzen angelegt wurden, einschließlich der Dateien des Redo-Logs.Wenn Sie MySQL auf dem Cluster-Host, wo der SQL-Knoten residieren soll, von RPM-Dateien installiert haben, können (und sollten) Sie das in

/etc/init.dinstallierte Startskript nutzen, um den MySQL Server-Prozess auf dem SQL-Knoten zu starten. Beachten Sie, dass Sie die-max-Server-RPM zusätzlich zur Standardserver-RPM installieren müssen, um die Binärversion von-max-Server ausführen zu können.

Wenn alles geklappt hat und der Cluster korrekt eingerichtet wurde, sollte er nun funktionsbereit sein. Dies können Sie testen, indem Sie den Management-Knoten-Client ndb_mgm aufrufen. Die Ausgabe sollte ungefähr dem Folgenden entsprechen, wobei jedoch je nach der verwendeten MySQL-Version kleinere Abweichungen möglich sind:

shell>ndb_mgm-- NDB Cluster -- Management Client -- ndb_mgm>SHOWConnected to Management Server at: localhost:1186 Cluster Configuration --------------------- [ndbd(NDB)] 2 node(s) id=2 @192.168.0.30 (Version: 5.1.5-alpha, Nodegroup: 0, Master) id=3 @192.168.0.40 (Version: 5.1.5-alpha, Nodegroup: 0) [ndb_mgmd(MGM)] 1 node(s) id=1 @192.168.0.10 (Version: 5.1.5-alpha) [mysqld(SQL)] 1 node(s) id=4 (Version: 5.1.5-alpha)

Hinweis: Wenn Sie eine ältere

Version von MySQL verwenden, wird der SQL-Knoten möglicherweise

als [mysqld(API)] bezeichnet. Das ist eine

ältere Lesart, die mittlerweile abgeschafft wurde.

Nun können Sie im MySQL Cluster mit Datenbanken, Tabellen und Daten arbeiten. Unter Abschnitt 16.3.5, „Beispieldaten einladen und Abfragen ausführen“, finden Sie eine kurze Beschreibung.

Der Umgang mit Daten im MySQL Cluster ist ganz ähnlich wie in einer MySQL-Konfiguration ohne Cluster. Nur auf zwei Dinge muss man achten:

Damit eine Tabelle im Cluster repliziert wird, muss die Speicher-Engine

NDB Clustermit der OptionENGINE=NDBoder der TabellenoptionENGINE=NDBCLUSTEReingeschaltet sein. Dies können Sie tun, wenn Sie die Tabelle anlegen:CREATE TABLE

tbl_name( ... ) ENGINE=NDBCLUSTER;Alternativ können Sie eine bereits vorhandene Tabelle, die eine andere Speicher-Engine verwendet, mit

ALTER TABLEaufNDB Clusterumstellen:ALTER TABLE

tbl_nameENGINE=NDBCLUSTER;Jede

NDB-Tabelle muss einen Primärschlüssel haben. Wenn der Benutzer beim Anlegen der Tabelle keinen definiert, wird von der Speicher-EngineNDB Clusterautomatisch ein verborgener Primärschlüssel generiert. (Hinweis: Dieser verborgene Schlüssel belegt Platz wie jeder andere Tabellenindex auch. Nicht selten treten Speicherplatzprobleme auf, wenn diese automatisch angelegten Indizes untergebracht werden müssen.)

Wenn Sie aus der Ausgabe von mysqldump

Tabellen aus einer vorhandenen Datenbank importieren, können

Sie das SQL-Skript mit einem Editor öffnen und die Option

ENGINE für alle Anweisungen einstellen, in

denen Tabellen angelegt werden, oder eine eventuell vorhandene

ENGINE- (oder TYPE-)Option

ersetzen. Nehmen wir an, Sie haben die Beispieldatenbank

world auf einem anderen MySQL Server liegen,

der MySQL Cluster nicht unterstützt, und Sie möchten die

Tabelle City exportieren:

shell> mysqldump --add-drop-table world City > city_table.sql

Die resultierende city_table.sql-Datei

enthält die folgende Anweisung zur Erzeugung einer Tabelle (und

die notwendigen INSERT-Anweisungen, um die

Tabellendaten zu importieren):

DROP TABLE IF EXISTS `City`;

CREATE TABLE `City` (

`ID` int(11) NOT NULL auto_increment,

`Name` char(35) NOT NULL default '',

`CountryCode` char(3) NOT NULL default '',

`District` char(20) NOT NULL default '',

`Population` int(11) NOT NULL default '0',

PRIMARY KEY (`ID`)

) ENGINE=MyISAM DEFAULT CHARSET=latin1;

INSERT INTO `City` VALUES (1,'Kabul','AFG','Kabol',1780000);

INSERT INTO `City` VALUES (2,'Qandahar','AFG','Qandahar',237500);

INSERT INTO `City` VALUES (3,'Herat','AFG','Herat',186800);

(restliche INSERT-Anweisungen ausgelassen)

Sie müssen gewährleisten, dass MySQL die Speicher-Engine NDB

für diese Tabelle verwendet. Dazu ändern Sie die Tabellendefinition

vor dem Import in die Cluster-Datenbank.

Die Definition der Tabelle City würde zum

Beispiel folgendermaßen modifiziert:

DROP TABLE IF EXISTS `City`;

CREATE TABLE `City` (

`ID` int(11) NOT NULL auto_increment,

`Name` char(35) NOT NULL default '',

`CountryCode` char(3) NOT NULL default '',

`District` char(20) NOT NULL default '',

`Population` int(11) NOT NULL default '0',

PRIMARY KEY (`ID`)

) ENGINE=NDBCLUSTER DEFAULT CHARSET=latin1;

INSERT INTO `City` VALUES (1,'Kabul','AFG','Kabol',1780000);

INSERT INTO `City` VALUES (2,'Qandahar','AFG','Qandahar',237500);

INSERT INTO `City` VALUES (3,'Herat','AFG','Herat',186800);

(remaining INSERT statements omitted)

Dies müssen Sie mit der Definition jeder Tabelle tun, die in

die geclusterte Datenbank importiert werden soll. Am einfachsten

erreichen Sie dies, indem Sie in der Datei mit den

Tabellendefinitionen alle Vorkommen von

TYPE=MyISAM oder

ENGINE=MyISAM durch

ENGINE=NDBCLUSTER ersetzen. Wenn Sie die

Datei nicht ändern möchten, können Sie die Tabellen auch mit

der unveränderten Datei anlegen und dann ihren Typ mit

ALTER TABLE ändern. Die Einzelheiten

erfahren Sie in einem späteren Abschnitt.

Wenn wir davon ausgehen, dass Sie bereits eine Datenbank namens

world auf dem SQL-Knoten des Clusters

angelegt haben, können Sie nun

city_table.sql mit dem

Kommandozeilen-Client mysql lesen und die

entsprechende Tabelle in der üblichen Weise mit Daten füllen:

shell> mysql world < city_table.sql

Dieser Befehl muss unbedingt auf dem Host ausgeführt werden,

auf welchem der SQL-Knoten läuft (in diesem Fall auf der

Maschine mit der IP-Adresse 192.168.0.20).

Um eine Kopie der gesamten world-Datenbank

auf dem SQL-Knoten anzulegen, führen Sie

mysqldump auf dem ungeclusterten Server aus,

um die Datenbank in die Datei world.sql im

Verzeichnis /usr/local/mysql/data zu

exportieren. Danach importieren Sie diese Datei folgendermaßen

in den SQL-Knoten des Clusters:

shell>cd /usr/local/mysql/datashell>mysql world < world.sql

Wenn Sie die Datei an einer anderen Stelle speichern, müssen Sie die obigen Anleitungen entsprechend abändern.

Sie müssen wissen, dass NDB Cluster in MySQL

5.1 nicht die selbstständige Erkennung von

Datenbanken unterstützt (siehe

Abschnitt 16.8, „Bekannte Beschränkungen von MySQL Cluster“). Mit anderen

Worten: Sobald Sie die Datenbank world und

ihre Tabellen auf einem Datenknoten angelegt haben, müssen Sie

die Anweisung CREATE SCHEMA world mit

nachfolgendem FLUSH TABLES auf jedem

SQL-Knoten im Cluster erteilen. Nur dann kann der Knoten die

Datenbank erkennen und ihre Tabellendefinitionen lesen.

SELECT-Anfragen werden auf dem SQL-Knoten

genau wie auf jedem anderen MySQL Server ausgeführt. Um

Anfragen auf der Kommandozeile auszuführen, müssen Sie sich

zuerst wie üblich in den MySQL Monitor einloggen (das Passwort

von root am Enter

password:-Prompt eingeben):

shell> mysql -u root -p

Enter password:

Welcome to the MySQL monitor. Commands end with ; or \g.

Your MySQL connection id is 1 to server version: 5.1.5-alpha

Type 'help;' or '\h' for help. Type '\c' to clear the buffer.

mysql>

Wir verwenden einfach das root-Konto des

MySQL Servers und gehen davon aus, dass Sie bei der Installation

des MySQL Servers die Standardsicherheitsvorkehrungen getroffen

und ein starkes root-Passwort eingerichtet

haben. Mehr darüber lesen Sie unter

Abschnitt 2.9.3, „Einrichtung der anfänglichen MySQL-Berechtigungen“.

Bitte achten Sie darauf, dass Cluster-Knoten, wenn sie

aufeinander zugreifen, nicht von dem MySQL-Berechtigungssystem

Gebrauch machen. Die Einrichtung oder Änderung von

MySQL-Benutzerkonten (einschließlich root)

wirkt sich nur auf Anwendungen aus, die auf den SQL-Knoten

zugreifen, aber nicht auf die Interaktion zwischen den Knoten.

Wenn Sie die ENGINE-Klauseln in den

Tabellendefinitionen vor dem Import des SQL-Skripts nicht

geändert hatten, sollten Sie nun folgende Anweisungen

ausführen:

mysql>USE world;mysql>ALTER TABLE City ENGINE=NDBCLUSTER;mysql>ALTER TABLE Country ENGINE=NDBCLUSTER;mysql>ALTER TABLE CountryLanguage ENGINE=NDBCLUSTER;

Auch die Auswahl einer Datenbank und die Ausführung einer SELECT-Anfrage auf einer Tabelle dieser Datenbank sowie das Schließen des MySQL Monitors funktionieren wie üblich:

mysql>USE world;mysql>SELECT Name, Population FROM City ORDER BY Population DESC LIMIT 5;+-----------+------------+ | Name | Population | +-----------+------------+ | Bombay | 10500000 | | Seoul | 9981619 | | São Paulo | 9968485 | | Shanghai | 9696300 | | Jakarta | 9604900 | +-----------+------------+ 5 rows in set (0.34 sec) mysql>\qBye shell>

Anwendungen, die MySQL nutzen, können ihre Standard-APIs auch

für den Zugriff auf NDB-Tabellen verwenden. Bitte denken Sie

jedoch daran, dass Ihre Anwendung auf den SQL-Knoten zugreifen

muss, und nicht auf den MGM- oder die Speicherknoten. Das

folgende kleine Beispiel zeigt, wie die obige

SELECT-Anweisung mithilfe der

mysqli-Erweiterung von PHP 5 ausgeführt

wird, die auf einem Webserver irgendwo anders im Netzwerk

läuft:

<!DOCTYPE HTML PUBLIC "-//W3C//DTD HTML 4.01 Transitional//EN"

"http://www.w3.org/TR/html4/loose.dtd">

<html>

<head>

<meta http-equiv="Content-Type"

content="text/html; charset=iso-8859-1">

<title>SIMPLE mysqli SELECT</title>

</head>

<body>

<?php

# Verbindung zum SQL-Knoten:

$link = new mysqli('192.168.0.20', 'root', 'root_password', 'world');

# Die Parameter für den mysqli-Konstruktor sind:

# Host, User, Passwort, Datenbank

if( mysqli_connect_errno() )

die("Connect failed: " . mysqli_connect_error());

$query = "SELECT Name, Population

FROM City

ORDER BY Population DESC

LIMIT 5";

# wenn keine Fehler auftreten...

if( $result = $link->query($query) )

{

?>

<table border="1" width="40%" cellpadding="4" cellspacing ="1">

<tbody>

<tr>

<th width="10%">City</th>

<th>Population</th>

</tr>

<?

# dann zeige Ergebnisse an...

while($row = $result->fetch_object())

printf(<tr>\n <td align=\"center\">%s</td><td>%d</td>\n</tr>\n",

$row->Name, $row->Population);

?>

</tbody

</table>

<?

# ...und prüfe, wie viele Zeilen abgerufen wurden

printf("<p>Affected rows: %d</p>\n", $link->affected_rows);

}

else

# anderenfalls sag uns, was schief gegangen ist

echo mysqli_error();

# gib die Ergebnismenge und das mysqli-Verbindungsobjekt frei

$result->close();

$link->close();

?>

</body>

</html>

Wir setzen voraus, dass der Prozess, der auf dem Webserver läuft, die IP-Adresse des SQL-Knotens erreichen kann.

In gleicher Weise können Sie die MySQL C-API, Perl-DBI, Python-mysql oder die eigenen Connectors der MySQL AB einsetzen, um die Aufgaben der Datendefinition und Datenbearbeitung genau so zu erledigen, wie Sie es auch normalerweise mit MySQL tun.

Um den Cluster herunterzufahren, geben Sie folgenden Befehl in eine Shell auf dem Host des MGM-Knotens ein:

shell> ndb_mgm -e shutdown

Hier wird die Option -e verwendet, um einen

Befehl von der Shell an den ndb_mgm-Client zu

übergeben. Siehe auch Abschnitt 4.3.1, „Befehlszeilenoptionen für mysqld“.

Mit diesem Befehl werden ndb_mgm,

ndb_mgmd und alle eventuell laufenden

ndbd-Prozesse geräuschlos beendet.

SQL-Knoten können mit mysqladmin shutdown

und anderen Methoden heruntergefahren werden.

Folgende Befehle starten den Cluster neu:

Auf dem Management-Host (in unserem Beispiel

192.168.0.10):shell>

ndb_mgmd -f /var/lib/mysql-cluster/config.iniAuf jedem der Daten-Hosts (

192.168.0.30und192.168.0.40):shell>

ndbdDenken Sie daran, dass Sie diesen Befehl nicht mit der Option

--initialaufrufen dürfen, wenn Sie einen NDBD-Knoten ganz normal neu starten.Auf dem SQL-Host (

192.168.0.20):shell>

mysqld &

Mehr über Datensicherungen im Cluster erfahren Sie unter Abschnitt 16.6.5.2, „Verwendung des Management-Servers zur Erzeugung von Backups“.

Um den Cluster aus einer Datensicherung wiederherzustellen, benötigen Sie den Befehl ndb_restore, der in Abschnitt 16.6.5.3, „Wiederherstellung aus einem Cluster-Backup“, erklärt wird.

Weitere Informationen über die Konfiguration von MySQL Cluster finden Sie unter Abschnitt 16.4, „MySQL Cluster: Konfiguration“.

Ein MySQL Server in einem MySQL Cluster unterscheidet sich nur in

einer Hinsicht von einem normalen (ungeclusterten) MySQL Server:

Er verwendet die Speicher-Engine NDB Cluster.

Diese Engine wird auch einfach als NDB

bezeichnet, beide Namen sind synonym.

Um nicht überflüssig Ressourcen zu reservieren, ist die

NDB-Engine in der Standardkonfiguration des

Servers ausgeschaltet. Um sie einzuschalten, müssen Sie die

Serverkonfigurationsdatei my.cnf ändern oder

den Server mit der Option --ndbcluster

hochfahren.

Da der MySQL Server Teil des Clusters ist, muss auch er wissen,

wie er einen MGM-Knoten erreicht, von dem er sich die

Cluster-Konfigurationsdaten besorgen kann. Nach Voreinstellung

sucht er den MGM-Knoten auf dem localhost. Wenn

Sie jedoch einen anderen Ort angeben müssen, so können Sie dies

in der Datei my.cnf oder auf der

Kommandozeile des MySQL Servers tun. Bevor die Speicher-Engine

NDB genutzt werden kann, müssen mindestens ein

MGM-Knoten sowie die erforderlichen Datenknoten funktionieren.

Die Speicher-Engine NDB für den

Cluster-Betrieb ist als Binärdistribution für Linux, Mac OS X

und Solaris erhältlich. Wir arbeiten daran, Cluster auf allen

von MySQL unterstützten Betriebssystemen einschließlich

Windows funktionsfähig zu machen.

Wenn Sie einen Build von einem Source Tarball oder dem MySQL

5.1 BitKeeper Tree bevorzugen, achten Sie darauf,

configure mit der Option

--with-ndbcluster auszuführen. Sie können

jedoch auch das Build-Skript

BUILD/compile-pentium-max laufen lassen.

Beachten Sie, dass dieses Skript OpenSSL enthält: Damit der

Build fehlerfrei läuft, müssen Sie also entweder OpenSSL

besitzen oder sich besorgen oder

compile-pentium-max umkonfigurieren, um

dieses Erfordernis herauszunehmen. Sie können natürlich auch

einfach die Standardinstruktionen für das Kompilieren Ihrer

eigenen Binaries befolgen und dann die üblichen Tests und

Installationsprozeduren durchführen. Siehe

Abschnitt 2.8.3, „Installation vom Entwicklungs-Source-Tree“.

In den folgenden Abschnitten wird vorausgesetzt, dass Sie mit der Installation von MySQL bereits vertraut sind. Daher behandeln wir hier nur die Unterschiede zwischen der Konfiguration eines geclusterten und eines ungeclusterten MySQL Servers. (Wenn Sie genauere Informationen benötigen, schauen Sie unter Kapitel 2, Installation von MySQL, nach.)

Am einfachsten ist die Cluster-Konfiguration, wenn alle

Management- und Datenknoten bereits laufen. Dies ist wohl der

langwierigste Teil der Konfiguration. Dagegen ist die

Bearbeitung der Datei my.cnf ziemlich

einfach und dieser Abschnitt wird lediglich beschreiben, wo die

Konfiguration von der des ungeclusterten MySQL Servers abweicht.

Um sich mit den Grundlagen vertraut zu machen, beschreiben wir zuerst die denkbar einfachste Konfiguration eines funktionsfähigen MySQL Clusters. Danach müssten Sie in der Lage sein, die von Ihnen gewünschte Startkonfiguration aus den Informationen der anderen zum Thema gehörenden Teile dieses Kapitels zu erschließen.

Zuerst müssen Sie ein Konfigurationsverzeichnis wie

beispielsweise /var/lib/mysql-cluster

anlegen, indem Sie folgenden Befehl als

System-root-User ausführen:

shell> mkdir /var/lib/mysql-cluster

In diesem Verzeichnis legen Sie eine Datei namens

config.ini an, die folgende Daten enthält.

Bitte setzen Sie für HostName und

DataDir die für Ihr System passenden Werte

ein.

# Die Datei "config.ini" zeigt eine Minimalkonfiguration, bestehend aus 1 Datenknoten, # 1 Management-Server und 3 MySQL Servern. # Die leeren Default-Abschnitte sind nicht erforderlich und werden nur der # Vollständigkeit halber gezeigt. # Die Datenknoten müssen einen Hostnamen angeben, nicht aber die MySQL Server. # Wenn Sie den Hostnamen Ihres Computers nicht wissen, verwenden Sie localhost. # Der Parameter DataDir hat ebenfalls einen Standardwert, sollte aber besser # explizit gesetzt werden. # Hinweis: DB, API und MGM sind Aliase für NDBD, MYSQLD und NDB_MGMD # DB und API sind veraltet und sollten in neuen # Installationen nicht mehr benutzt werden. [NDBD DEFAULT] NoOfReplicas= 1 [MYSQLD DEFAULT] [NDB_MGMD DEFAULT] [TCP DEFAULT] [NDB_MGMD] HostName= myhost.example.com [NDBD] HostName= myhost.example.com DataDir= /var/lib/mysql-cluster [MYSQLD] [MYSQLD] [MYSQLD]

Sie können jetzt den Management-Server

ndb_mgmd starten. Da dieser standardmäßig

versucht, die Datei config.ini in seinem

aktuellen Arbeitsverzeichnis zu lesen, müssen Sie in das

Verzeichnis wechseln, in dem die Datei sich befindet, und dann

ndb_mgmd aufrufen:

shell>cd /var/lib/mysql-clustershell>ndb_mgmd

Danach starten Sie einen einzelnen DB-Knoten mit dem Befehl

ndbd. Wenn Sie ndbd zum

allerersten Mal für einen DB-Knoten starten, müssen Sie die

Option --initial einsetzen:

shell> ndbd --initial

Bei allen weiteren Starts von ndbd müssen

Sie die --initial-Option unbedingt

weglassen:

shell> ndbd

Der Grund, weshalb die Option --initial bei

weiteren Neustarts nicht wieder benutzt werden darf, ist der,

dass sie ndbd veranlasst, alle vorhandenen

Daten- und Logdateien (und alle Metadaten für Tabellen) dieses

Datenknotens zu löschen und neu zu erzeugen. Die einzige

Ausnahme von dieser Regel, --initial nur für

den allerersten Aufruf von ndbd zu verwenden,

tritt dann ein, wenn der Cluster neu gestartet und nach dem

Hinzufügen neuer Datenknoten aus den Sicherungsdateien

wiederhergestellt wird.

Nach Voreinstellung sucht ndbd den

Management-Server auf localhost am Port 1186.

Hinweis: Wenn Sie MySQL von

einem Binary Tarball installiert haben, müssen Sie den Pfad der

ndb_mgmd- und ndbd-Server

explizit angeben. (Normalerweise befinden sich die beiden in

/usr/local/mysql/bin.)

Zum Schluss gehen Sie in das MySQL-Datenverzeichnis

(normalerweise /var/lib/mysql oder

/usr/local/mysql/data) und sorgen dafür,

dass die Datei my.cnf die Option enthält,

die zur Aktivierung der Speicher-Engine NDB erforderlich ist:

[mysqld] ndbcluster

Jetzt können Sie den MySQL Server wie gewöhnlich starten:

shell> mysqld_safe --user=mysql &

Warten Sie einen Augenblick, um sich zu vergewissern, dass der

MySQL Server richtig läuft. Wenn Sie die Meldung mysql

ended sehen, schauen Sie in die

.err-Datei des Servers, um den Fehler zu

finden.

Wenn so weit alles geklappt hat, können Sie den Server nun

geclustert starten. Verbinden Sie sich mit dem Server und

schauen Sie nach, ob die Speicher-Engine

NDBCLUSTER aktiviert ist:

shell>mysqlWelcome to the MySQL monitor. Commands end with ; or \g. Your MySQL connection id is 1 to server version: 5.1.5-alpha-Max Type 'help;' or '\h' for help. Type '\c' to clear the buffer. mysql>SHOW ENGINES\G... *************************** 12. row *************************** Engine: NDBCLUSTER Support: YES Comment: Clustered, fault-tolerant, memory-based tables *************************** 13. row *************************** Engine: NDB Support: YES Comment: Alias for NDBCLUSTER ...

Die Zeilennummern der obigen Ausgabe können auf Ihrem System je nach Ihrer Serverkonfiguration abweichen.

Versuchen Sie nun, eine NDBCLUSTER-Tabelle

anzulegen:

shell>mysqlmysql>USE test;Database changed mysql>CREATE TABLE ctest (i INT) ENGINE=NDBCLUSTER;Query OK, 0 rows affected (0.09 sec) mysql>SHOW CREATE TABLE ctest \G*************************** 1. row *************************** Table: ctest Create Table: CREATE TABLE `ctest` ( `i` int(11) default NULL ) ENGINE=ndbcluster DEFAULT CHARSET=latin1 1 row in set (0.00 sec)

Um zu prüfen, ob Ihre Knoten richtig eingerichtet sind, starten Sie den Management-Client:

shell> ndb_mgm

Innerhalb des Management-Clients geben Sie den Befehl SHOW ein, um einen Statusbericht über den Cluster zu erhalten:

NDB> SHOW

Cluster Configuration

---------------------

[ndbd(NDB)] 1 node(s)

id=2 @127.0.0.1 (Version: 3.5.3, Nodegroup: 0, Master)

[ndb_mgmd(MGM)] 1 node(s)

id=1 @127.0.0.1 (Version: 3.5.3)

[mysqld(API)] 3 node(s)

id=3 @127.0.0.1 (Version: 3.5.3)

id=4 (not connected, accepting connect from any host)

id=5 (not connected, accepting connect from any host)

Nun haben Sie mit Erfolg einen funktionierenden MySQL Cluster

eingerichtet. In diesen Cluster können Sie jetzt aus jeder

Tabelle, die mit ENGINE=NDBCLUSTER oder

seinem Alias ENGINE=NDB angelegt wurde, Daten

laden.

- 16.4.4.1. Beispielkonfiguration eines MySQL Clusters

- 16.4.4.2. MySQL Cluster:

connectstring - 16.4.4.3. Festlegung der Computer, aus denen ein MySQL Cluster besteht

- 16.4.4.4. Festlegung des MySQL Cluster-Management-Servers

- 16.4.4.5. Festlegen von MySQL Cluster-Datenknoten

- 16.4.4.6. Festlegung von SQL-Nodes in einem MySQL Cluster

- 16.4.4.7. MySQL Cluster: TCP/IP-Verbindungen

- 16.4.4.8. MySQL Cluster: TCP/IP-Verbindungen mittels direkter Verbindungen

- 16.4.4.9. MySQL Cluster: Shared Memory-Verbindungen

- 16.4.4.10. MySQL Cluster: SCI-Transportverbindungen

Um MySQL Cluster zu konfigurieren, müssen Sie mit zwei Dateien arbeiten:

my.cnf: Hier sind Optionen für alle Executables im MySQL Cluster angegeben. Diese Datei, die Ihnen aus der früheren Arbeit mit MySQL bereits vertraut sein dürfte, muss jeder ausführbaren Datei im Cluster zugänglich sein.config.ini: Diese Datei wird nur vom Management-Server im MySQL Cluster gelesen, der dann die in ihr enthaltenen Informationen an alle Prozesse im Cluster weiterleitet.config.inienthält eine Beschreibung für jeden am Cluster beteiligten Knoten. Dazu gehören Konfigurationsparameter für Datenknoten sowie Konfigurationsparameter für Verbindungen zwischen sämtlichen Knoten im Cluster.

Wir arbeiten permanent daran, die Cluster-Konfiguration zu verbessern und diesen Prozess zu vereinfachen. Auch wenn wir uns dabei um Abwärtskompatibilität bemühen, können auch gelegentlich inkompatible Änderungen vorkommen. In solchen Fällen teilen wir den Benutzern von Cluster im Voraus mit, wenn eine Änderung nicht abwärtskompatibel ist. Wenn Sie auf eine noch undokumentierte Änderung dieser Art stoßen sollten, melden Sie sie bitte der MySQL-Bugs-Datenbank nach dem in Abschnitt 1.8, „Wie man Bugs oder Probleme meldet“, beschriebenen Verfahren.

Um MySQL Cluster zu unterstützen, müssen Sie die Datei

my.cnf so ändern, wie es im folgenden

Beispiel gezeigt wird. Bitte verwechseln Sie die hier

angegebenen Optionen nicht mit denen aus den

config.ini-Dateien. Sie können diese

Parameter auch auf der Kommandozeile angeben, wenn Sie die

Executables aufrufen.

# my.cnf # Beispiel für Ergänzungen der my.cnf für MySQL Cluster # (gilt für MySQL 5.1) # ndbcluster-Speicher-Engine aktivieren und Verbindungs-String für # Management-Server-Host anlegen (Standardport ist 1186) [mysqld] ndbcluster ndb-connectstring=ndb_mgmd.mysql.com # Verbindungs-String für Management-Server-Host anlegen (Standardport ist 1186) [ndbd] connect-string=ndb_mgmd.mysql.com # Verbindungs-String für Management-Server-Host anlegen (Standardport ist 1186) [ndb_mgm] connect-string=ndb_mgmd.mysql.com # Speicherort für Cluster-Konfigurationsdatei [ndb_mgmd] config-file=/etc/config.ini

(Weitere Informationen über Connectstrings finden Sie unter

Abschnitt 16.4.4.2, „MySQL Cluster: connectstring“.)

# my.cnf # Beispiel für Ergänzungen der my.cnf für MySQL Cluster # (funktioniert auf allen Versionen) # ndbcluster-Speicher-Engine aktivieren und Verbindungs-String für # Management-Server-Host anlegen (Standardport ist 1186 [mysqld] ndbcluster ndb-connectstring=ndb_mgmd.mysql.com:1186

Sie können in der Cluster-my.cnf-Datei

auch einen separaten

[mysql_cluster]-Abschnitt für

Einstellungen einrichten, die von allen Executables gelesen

und benutzt werden:

# Cluster-spezifische Einstellungen [mysql_cluster] ndb-connectstring=ndb_mgmd.mysql.com:1186

Die Konfigurationsdatei heißt nach Voreinstellung

config.ini. Sie wird von

ndb_mgmd beim Starten gelesen und kann an

jedem beliebigen Ort gespeichert sein. Ihr Speicherort und ihr

Name werden mit

--config-file=

auf der Kommandozeile für ndb_mgmd

angegeben. Wenn die Konfigurationsdatei nicht angegeben wurde,

versucht ndb_mgmd nach Voreinstellung, eine

Datei namens path_nameconfig.ini im aktuellen

Arbeitsverzeichnis zu lesen.

Gegenwärtig hat die Konfiguration ein INI-Format: Sie besteht

also aus Abschnitten mit Abschnittsüberschriften (in eckigen

Klammern), gefolgt von den jeweiligen Parameternamen und

-werten. Sie weicht insofern vom Standard-INI-Format ab, als

der Name und Wert eines Parameters auch durch einen

Doppelpunkt (‘:’) und nicht nur

durch das Gleichheitszeichen

(‘=’) getrennt sein können und

die Abschnitte nicht eindeutig durch einen Abschnittsnamen

identifiziert sind. Stattdessen werden eindeutige Abschnitte

(wie zum Beispiel zwei verschiedene Knoten desselben Typs)

durch eine eindeutige ID gekennzeichnet, die innerhalb des

Abschnitts als Parameter angegeben ist.

Für die meisten Parameter sind Standardwerte definiert. Diese

können auch in config.ini angegeben

sein. Um einen Abschnitt für Standardwerte anzulegen, fügen

Sie dem Abschnittsnamen einfach DEFAULT

hinzu. Zum Beispiel enthält ein

[NDBD]-Abschnitt Parameter für einen

bestimmten Datenknoten, während ein[NDBD

DEFAULT]-Abschnitt Parameter enthält, die für

sämtliche Datenknoten gelten. Wir nehmen an, dass alle

Datenknoten denselben Speicherplatz belegen. Um sie alle zu

konfigurieren, legen Sie also einen [NDBD

DEFAULT]-Abschnitt mit einer

DataMemory-Zeile an, in welcher der

Speicherplatz für die Datenknoten angegeben ist.

Die Konfigurationsdatei muss mindestens die Computer und Knoten eines Clusters aufführen und sagen, auf welchem Computer welcher Knoten residiert. Im Folgenden sehen Sie ein Beispiel einer einfachen Konfigurationsdatei für einen Cluster, der aus einem Management-Server, zwei Datenknoten und zwei MySQL Servern besteht:

# Datei "config.ini" - 2 Datenknoten und 2 SQL-Knoten # Diese Datei wird in das Startverzeichnis von ndb_mgmd (dem # Management-Server gelegt.) # Der erste MySQL Server kann von jedem Host gestartet werden, der zweite # nur vom Host mysqld_5.mysql.com [NDBD DEFAULT] NoOfReplicas= 2 DataDir= /var/lib/mysql-cluster [NDB_MGMD] Hostname= ndb_mgmd.mysql.com DataDir= /var/lib/mysql-cluster [NDBD] HostName= ndbd_2.mysql.com [NDBD] HostName= ndbd_3.mysql.com [MYSQLD] [MYSQLD] HostName= mysqld_5.mysql.com

Beachten Sie, dass jeder Knoten seinen eigenen Abschnitt in

config.ini hat. Da der vorliegende

Cluster zwei Datenknoten hat, enthält die Konfigurationsdatei

zwei [NDBD]-Abschnitte, in denen diese

Knoten definiert sind.

In der config.ini-Konfigurationsdatei

können sechs verschiedene Abschnitte benutzt werden:

[COMPUTER]: Definiert die Cluster-Hosts.[NDBD]: Definiert die Daten des Clusters nodes.[MYSQLD]: Definiert die MySQL Server-Knoten des Clusters server nodes.[MGM]or[NDB_MGMD]: Definiert den Management-Server-Knoten des Clusters.[TCP]: Definiert die TCP/IP-Verbindungen zwischen den Knoten im Cluster, wobei TCP/IP das Standardverbindungsprotokoll ist.[SHM]: Definiert Shared-Memory-Verbindungen zwischen Knoten. Früher stand dieser Verbindungtyp nur in Binaries zur Verfügung, die mit der Option--with-ndb-shmgebaut wurden. In MySQL 5.1-Max ist er nach Voreinstellung eingeschaltet, allerdings befindet sich diese Lösung noch in der Erprobungsphase.

Für jeden Abschnitt können Sie auch

DEFAULT-Werte definieren.

Cluster-Parameternamen unterscheiden im Gegensatz zu den

Parametern in my.cnf oder

my.ini nicht zwischen Groß- und

Kleinschreibung.

Mit Ausnahme des MySQL Cluster-Management-Servers (ndb_mgmd) benötigt jeder zu einem MySQL Cluster gehörige Knoten einen Verbindungs-String (Connectstring), der auf den Standort des Management-Servers verweist. Dieser Verbindungs-String wird zum Einrichten einer Verbindung mit dem Management-Server und, je nach der Rolle des Knotens im Cluster, auch für die Erfüllung anderer Aufgaben benötigt. Ein Verbindungs-String hat folgende Syntax:

<connectstring> :=

[<nodeid-specification>,]<host-specification>[,<host-specification>]

<nodeid-specification> := node_id

<host-specification> := host_name[:port_num]

node_id ist ein Integer größer 1, der

einen Knoten in config.ini bezeichnet.

host_name ist ein String, der einen

gültigen Internethostnamen oder eine IP-Adresse angibt.

port_num ist ein Integer, der auf

eine TCP/IP-Portnummer verweist.

example 1 (long): "nodeid=2,myhost1:1100,myhost2:1100,192.168.0.3:1200" example 2 (short): "myhost1"

Alle Knoten verwenden localhost:1186 als

Standardwert für den Verbindungs-String, wenn kein anderer

angegeben wird. Wenn port_num aus

dem Verbindungs-String weggelassen wird, ist 1186 der

Standardport. Dieser sollte im Netzwerk immer frei sein, da er

von der IANA genau diesen Zweck zugewiesen bekam (siehe

http://www.iana.org/assignments/port-numbers

for details).

Durch Auflistung mehrerer

<host-specification>-Werte können

Sie redundante Management-Server angeben. Ein Cluster-Knoten

wird dann versuchen, der Reihe nach mehrere Management-Server

auf jedem Host zu kontaktieren, bis er eine Verbindung

einrichten kann.

Der Verbindungs-String kann auf verschiedene Weisen angegeben werden:

Jede Executable hat ihre eigene Kommandozeilenoption, um den Management-Server beim Starten anzugeben. (In der Dokumentation finden Sie die jeweilige Executable.)

Sie können auch die Verbindungs-Strings für alle Knoten des Clusters zugleich einrichten, indem Sie sie in den

[mysql_cluster]-Abschnitt dermy.cnf-Datei des Management-Servers schreiben.Aus Gründen der Abwärtskompatibilität stehen auch zwei weitere Optionen mit gleicher Syntax zur Verfügung:

Sie können die Umgebungsvariable

NDB_CONNECTSTRINGauf den Verbindungs-String einstellen.Sie können den Verbindungs-String für jede Executable in eine Textdatei namens

Ndb.cfgschreiben und diese Datei in das Startverzeichnis der Executable legen.

Diese beiden Möglichkeiten sind jedoch inzwischen veraltet und sollten für neuere Installationen nicht mehr verwendet werden.

Wir empfehlen, den Verbindungs-String entweder auf der

Kommandozeile oder in der Datei my.cnf

für jede Executable anzugeben.

Die einzige Bedeutung des Abschnitts

[COMPUTER] besteht darin, nicht für jeden

Knoten im System Hostnamen definieren zu müssen. Alle hier

angegebenen Parameter sind obligatorisch.

IdEin Integer-Wert, der auf einen anderswo in der Konfigurationsdatei angegebenen Hostcomputer verweist.

HostNameDer Hostname oder die IP-Adresse des Computers.

Im Abschnitt [NDB_MGMD] wird das Verhalten

des Management-Servers konfiguriert. [MGM]

kann auch als Alias verwendet werden; beide Abschnittsnamen

sind äquivalent. Alle Parameter in der folgenden Liste sind

optional; wenn man sie weglässt, werden Standardwerte

verwendet. Hinweis: Wenn

weder der Parameter ExecuteOnComputer noch

ein HostName angegeben ist, wird

localhost für beide als Default

eingesetzt.

IdJeder Knoten im Cluster hat eine eindeutige Identität, die durch einen Integer-Wert zwischen 1 und 63 (einschließlich) dargestellt wird. Alle Nachrichten im Cluster sprechen den Knoten mit dieser ID an.

ExecuteOnComputerBezieht sich auf einen der im Abschnitt

[COMPUTER]aufgeführten Computer.PortNumberDie Nummer des Ports, auf welchem der Management-Server auf Konfigurationsanforderungen und Management-Befehle lauscht.

LogDestinationDieser Parameter gibt an, wohin die Logdaten für den Cluster gesandt werden: an

CONSOLE,SYSLOGoderFILE:CONSOLEgibt das Log anstdoutaus:CONSOLE

SYSLOGsendet das Log ansyslog, wobei einer der folgenden Werte verwendet wird:auth,authpriv,cron,daemon,ftp,kern,lpr,mail,news,syslog,user,uucp,local0,local1,local2,local3,local4,local5,local6oderlocal7.Hinweis: Nicht jedes Betriebssystem unterstützt alle diese Werte.

SYSLOG:facility=syslog

FILEsendet die Ausgabe des Cluster-Logs an eine normale Datei auf demselben Computer. Folgende Werte können angegeben werden:filename: Der Name der Logdatei.maxsize: Die Maximalgröße (in Bytes), auf welche die Datei anwachsen kann, ehe das Log in einer neuen Datei fortgesetzt wird. Wenn dies geschieht, wird die alte Logdatei umbenannt, indem ein.Nan ihren Dateinamen angefügt wird, wobeiNdie nächste laufende Nummer ist, die noch nicht für diesen Dateinamen eingesetzt wurde.maxfiles: Die maximale Anzahl der Logdateien.

FILE:filename=cluster.log,maxsize=1000000,maxfiles=6

In der folgenden Form können auch mehrere Logdestinationen, jeweils durch Semikola getrennt, angegeben werden:

CONSOLE;SYSLOG:facility=local0;FILE:filename=/var/log/mgmd

Der Parameter

FILEhat folgenden Standardwert:FILE:filename=ndb_.node_id_cluster.log,maxsize=1000000,maxfiles=6node_idist dabei die ID des Knotens.

ArbitrationRankMit diesem Parameter wird angegeben, welche Knoten als Arbitrator fungieren können. Nur MGM- und SQL-Knoten können Arbitrator sein. Der

ArbitrationRankcan take ist einer der folgenden Werte:0: Dieser Knoten wird nie als Arbitrator eingesetzt.1: Da dieser Knoten eine hohe Priorität hat, wird er eher als Knoten mit niedriger Priorität als Arbitrator eingesetzt.2: Ein Knoten mit niedriger Priorität, der als Arbitrator nur eingesetzt wird, wenn kein Knoten mit höherer Priorität für diesen Zweck verfügbar ist.

Normalerweise sollte der Management-Server als Arbitrator konfiguriert werden, indem sein

ArbitrationRankauf 1 (den Default) und der Rang aller SQL-Knoten auf 0 gesetzt wird.ArbitrationDelayEin Integer-Wert, der angibt, um wie viele Millisekunden die Antworten des Management-Servers auf Arbitration-Requests verzögert werden. Der Standardwert 0 muss normalerweise nicht geändert werden.

DataDirDas Verzeichnis, in dem die Ausgabedateien des Management-Servers gespeichert werden. Dazu gehören die Cluster-Logdateien, die Prozess-Ausgabedateien und die Prozess-ID (PID)-Datei des Daemons. (Für die Logdateien können Sie auch einen anderen Speicherort einstellen, indem Sie, wie weiter oben in diesem Abschnitt beschrieben, den Parameter

FILEfür dieLogDestinationeinstellen.)

Im Abschnitt [NDBD] wird das Verhalten der

Datenknoten des Clusters konfiguriert. Es gibt eine Vielzahl

Parameter für die Größen von Puffern und Pools, für

Timeout-Werte und so weiter. Die einzigen obligatorischen

Parameter sind:

entweder

ExecuteOnComputeroderHostNameder Parameter

NoOfReplicas

Diese obligatorischen Parameter müssen im Abschnitt

[NDBD DEFAULT] definiert werden.

Die meisten Parameter für Datenknoten werden im Abschnitt

[NDBD DEFAULT] gesetzt. Nur die Parameter,

von denen explizit gesagt wird, dass sie lokale Werte

einstellen können, dürfen im

[NDBD]-Abschnitt geändert werden.

HostName, Id und

ExecuteOnComputer müssen

unbedingt im lokalen

[NDBD]-Abschnitt definiert sein.

Datenknoten identifizieren

Der Wert Id (der Datenknoten-Bezeichner)

kann entweder auf der Kommandozeile beim Starten des Knotens

oder in der Konfigurationsdatei zugewiesen werden.

An jeden Parameter kann als Suffix K,

M oder G angehängt

werden, um Einheiten von 1.024, 1.024 × 1.024 oder 1.024

× 1.024 × 1.024 anzugeben. (So bedeutet

beispielsweise 100K 100 × 1.024 =

102.400.) In Parameternamen und -werten wird zwischen Groß-

und Kleinschreibung unterschieden.

IdDiese Knoten-ID ist die Adresse des Knotens für alle internen Nachrichten im Cluster. Sie ist ein Integer zwischen 1 und 63 einschließlich. Jeder Knoten im Cluster muss eine eindeutige Identität haben.

ExecuteOnComputerBezieht sich auf einen der Computer (Hosts), die im Abschnitt

COMPUTERdefiniert sind.HostNameDie Angabe dieses Parameters wirkt sich ähnlich wie die Angabe von

ExecuteOnComputeraus: Er definiert den Hostnamen des Computers, auf dem der Speicherknoten liegen soll. Wenn Sie einen anderen Hostnamen alslocalhostangeben möchten, müssen Sie entweder diesen Parameter oderExecuteOnComputerverwenden.ServerPort(OBSOLETE)Jeder Knoten im Cluster verbindet sich mit anderen Computern über einen Port. Dieser Port wird beim Einrichten der Verbindung auch für Nicht-TCP-Transporter verwendet. Der Standardport wird dynamisch in einer Weise zugewiesen, die gewährleistet, dass keine zwei Knoten auf demselben Computer die gleiche Portnummer bekommen. Daher dürfte es sich normalerweise erübrigen, einen Wert für diesen Parameter zu setzen.

NoOfReplicasDieser globale Parameter kann nur im Abschnitt

[NDBD DEFAULT]eingestellt werden und definiert, wie viele Replikas jeder Tabelle im Cluster gespeichert werden. Außerdem gibt dieser Parameter die Größe der Knotengruppen an. Eine Knotengruppe ist eine Menge von Knoten, die alle dieselben Informationen speichern.Knotengruppen werden implizit gebildet. Die erste Knotengruppe besteht aus der Menge der Datenknoten mit den niedrigsten Knoten-IDs, die nächste aus der Menge der Datenknoten mit den zweitniedrigsten IDs und so weiter. Nehmen wir als Beispiel an, wir hätten 4 Datenknoten und die

NoOfReplicaswurde auf 2 gesetzt. Die vier Datenknoten haben die IDs 2, 3, 4 und 5. Dann besteht die erste Gruppe aus den Knoten 2 und 3 und die zweite Gruppe aus den Knoten 4 und 5. Es ist wichtig, den Cluster so zu konfigurieren, dass Knoten derselben Gruppe nicht auf demselben Computer liegen, da ein einziger Hardwareabsturz dann den gesamten Cluster zerstören würde.Wenn keine Knoten-IDs angegeben werden, entscheidet die Reihenfolge der Datenknoten über ihre Zugehörigkeit zu einer Knotengruppe. Egal ob explizit zugewiesen oder nicht, die

SHOW-Ausgabe auf dem Management-Client zeigt die Knotengruppen an.NoOfReplicashat keinen Standardwert, der größtmögliche Wert beträgt 4.DataDirDieser Parameter gibt das Verzeichnis für die Trace-Dateien, Logdateien, PID-Dateien und Fehlerlogs an.

FileSystemPathDieser Parameter gibt an, in welchem Verzeichnis alle Dateien gespeichert werden, die für Metadaten, REDO-Logs, UNDO-Logs und Datendateien angelegt werden. Nach Voreinstellung ist dies das in

DataDirangegebene Verzeichnis. Hinweis: Dieses Verzeichnis muss existieren, bevor der ndbd-Prozess gestartet wird.Die empfohlene Verzeichnishierarchie für MySQL Cluster beginnt mit dem Verzeichnis

/var/lib/mysql-cluster, unter dem dann ein Verzeichnis für das Dateisystem des Knotens angelegt wird. Der Name dieses Unterverzeichnisses enthält die Knoten-ID. Wenn beispielsweise die Knoten-ID die 2 ist, heißt das Unterverzeichnisndb_2_fs.BackupDataDirDieser Parameter sagt, in welches Verzeichnis die Sicherungsdateien gespeichert werden. Wird nichts angegeben, ist ein Verzeichnis namens

BACKUPunter dem im ParameterFileSystemPathangegebenen Speicherort das Standardverzeichnis (siehe oben.)

Data Memory und Index Memory

DataMemory und

IndexMemory sind

[NDBD]-Parameter, in denen die Größe der

Speichersegmente festgelegt wird, welche die tatsächlichen

Datensätze und ihre Indizes speichern. Für die Einstellung

dieser Parameter müssen Sie unbedingt wissen, wie

DataMemory und

IndexMemory verwendet werden, da diese

Werte normalerweise an die tatsächliche Speichernutzung des

Clusters angepasst werden müssen:

DataMemoryDieser Parameter besagt, wie viel Speicherplatz (in Bytes) für die Speicherung der Datenbankeinträge zur Verfügung stehen muss. Da im Arbeitsspeicher der gesamte hier angegebene Speicherplatz zugewiesen wird, ist es extrem wichtig, dass der physikalische Arbeitsspeicher des Computers groß genug ist, um diesen auch unterbringen zu können.

Der durch

DataMemoryzugewiesene Speicher wird sowohl für die Datensätze als auch für ihre Indizes verwendet. Jeder Datensatz hat zurzeit noch eine feste Größe (sogarVARCHAR-Spalten werden als Spalten fester Breite gespeichert). Für jeden Datensatz gibt es einen Overhead von 16 Byte. Zusätzlich wird noch weiterer Platz für jeden Datensatz zugewiesen, da er in einer 32-Kbyte-Seite mit 128 Byte Seiten-Overhead gespeichert wird (siehe unten). Zudem wird für jede Seite ein wenig Platz verschwendet, da jeder Datensatz in ein- und derselben Seite gespeichert werden muss. Die Maximalgröße eines Datensatzes beträgt gegenwärtig 8.052 Byte.Der in

DataMemorydefinierte Speicherplatz wird auch zur Unterbringung von Indizes genutzt, die rund 10 Byte pro Datensatz belegen. Jede Tabellenzeile wird im geordneten Index dargestellt. Oft nehmen Anwender fälschlich an, dass alle Indizes in dem Speicher desIndexMemoryabgelegt werden, doch dies ist nicht der Fall: Nur Primärschlüssel und eindeutige Hash-Indizes nutzen diesen Speicher, während geordnete Indizes den vonDataMemoryzugewiesenen Speicher belegen. Wenn Sie jedoch einen Primärschlüssel oder einen eindeutigen Hash-Index anlegen, wird zugleich auf denselben Schlüsseln auch ein geordneter Index erzeugt, sofern Sie nicht in der IndexanweisungUSING HASHgesagt haben. Dies können Sie prüfen, indem Sie ndb_desc -ddb_nametable_nameim Management-Client ausführen.Der für das

DataMemoryzugewiesene Speicherplatz besteht aus 32-Kbyte-Seiten, die den Tabellenfragmenten zugeordnet werden. Jede Tabelle wird normalerweise in ebenso viele Fragmente partitioniert, wie der Cluster Datenknoten hat. Also sind für jeden Knoten so viele Fragmente vorhanden, wie inNoOfReplicaseingestellt sind. Gegenwärtig ist es nicht möglich, eine einmal zugewiesene Seite dem Pool der freien Seiten zurückzugeben, außer man löscht die Tabelle. Auch durch eine Knotenwiederherstellung wird die Partition kleiner, da alle Datensätze in leere Partitionen anderer Live-Knoten geschrieben werden.Der Speicherplatz im

DataMemoryenthält auch UNDO-Informationen: Bei jedem Update wird eine Kopie des unveränderten Datensatzes in dasDataMemorygeschrieben. Außerdem wird jede Kopie in den geordneten Tabellenindizes referenziert. Eindeutige Hash-Indizes werden nur aktualisiert, wenn die eindeutigen Indexspalten sich ändern. In diesem Fall wird ein neuer Eintrag in die Indextabelle eingefügt und der alte beim Committen gelöscht. Aus diesem Grunde ist es auch notwendig, genug Speicherplatz zu reservieren, um selbst die größten Transaktionen von Anwendungen, die diesen Cluster nutzen, noch behandeln zu können. Wenige große Transaktionen auszuführen ist jedenfalls nicht besser, als viele kleine zu verwenden. Dafür gibt es folgende Gründe:Große Transaktionen sind nicht schneller als kleinere.

Wenn eine Transaktion scheitert, müssen bei großen Transaktionen mehr Operationen wiederholt werden, weil sie verloren gegangen sind.

Große Transaktionen belegen mehr Speicherplatz.

Der Standardwert für das

DataMemorybeträgt 80 Mbyte und der Mindestwert 1 Mbyte. Es gibt keinen Höchstwert, aber in der Praxis muss die Maximalgröße natürlich so angepasst werden, dass der Prozess nicht anfängt, auf die Platte zu schreiben, wenn das Limit erreicht wird. Dieses Limit hängt von der Größe des auf dem Computer verfügbaren physikalischen Arbeitsspeichers ab sowie von der Frage, wie viel Speicher das Betriebssystem einem einzelnen Prozess zuweisen kann. 32-Bit-Betriebssysteme sind generell auf 2 bis 4 Gbyte pro Prozess beschränkt, während 64-Bit-Betriebssysteme mehr Speicher verwenden können. Aus diesem Grunde eignen sich 64-Bit-Systeme für große Datenbanken besser. Überdies ist es möglich, mehrere ndbd-Prozesse pro Computer auszuführen. Dies kann bei Maschinen mit mehreren CPUs Vorteile bringen.IndexMemoryDieser Parameter gibt an, wie viel Speicher für Hash-Indizes in MySQL Cluster benutzt wird. Hash-Indizes werden immer für Primärschlüsselindizes, eindeutige Indizes und Unique-Constraints verwendet. Achtung: Wenn Sie einen Primärschlüssel und einen eindeutigen Index definieren, werden zwei Indizes angelegt, von denen einer ein Hash-Index ist, der für alle Tupel-Zugriffe, für die Sperren und für die Durchsetzung von Unique-Constraints verwendet wird.

Die Größe des Hash-Indexes beträgt 25 Byte pro Datensatz plus die Größe des Primärschlüssels. Für Primärschlüssel, die mehr als 32 Byte belegen, werden weitere 8 Byte addiert.

Der Standardwert für

IndexMemorybeträgt 18 Mbyte, der Mindestwert 1 Mbyte.

Das folgende Beispiel zeigt, wie Speicher für eine Tabelle zugewiesen wird. Betrachten Sie folgende Tabellendefinition:

CREATE TABLE example ( a INT NOT NULL, b INT NOT NULL, c INT NOT NULL, PRIMARY KEY(a), UNIQUE(b) ) ENGINE=NDBCLUSTER;

Für jeden Datensatz sind 12 Byte Daten plus 12 Byte Overhead

zugewiesen. Wenn keine Spalten dabei sind, die Nullwerte

annehmen können, so spart dies 4 Byte Overhead. Außerdem